온라인 금칙어 필터링 도구는 웹 서비스와 애플리케이션에서 부적절한 콘텐츠를 자동으로 차단하는 필수 시스템으로,

실시간 금칙어 검사와 다양한 프로그래밍 언어 구현 방법을 통해 안전한 디지털 환경을 구축할 수 있습니다.

현대 웹 서비스에서 사용자 생성 콘텐츠(UGC)가 증가하면서 금칙어 검사기의 중요성이 더욱 커지고 있습니다.

댓글, 게시글, 채팅 등 다양한 형태의 사용자 입력에서 부적절한 표현을 필터링하는 것은 건전한 온라인 문화 조성의 핵심입니다.

금칙어 검사기란 무엇인가?

금칙어 검사기는 텍스트 내용을 분석하여 미리 정의된 금지어나 부적절한 표현을 탐지하고 필터링하는 시스템입니다.

이러한 도구는 웹사이트, 모바일 앱, 게임, 소셜 미디어 플랫폼 등에서 광범위하게 활용되고 있습니다.

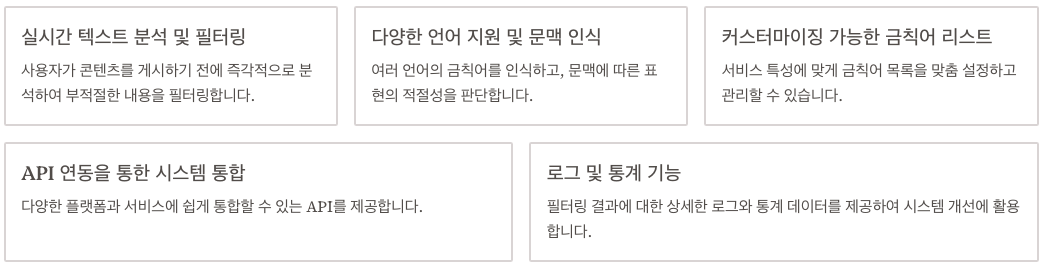

금칙어 검사기의 주요 기능

- 실시간 텍스트 분석 및 필터링

- 다양한 언어 지원 및 문맥 인식

- 커스터마이징 가능한 금칙어 리스트 관리

- API 연동을 통한 시스템 통합

- 로그 및 통계 기능

금칙어 필터링 도구는 단순한 키워드 매칭부터 고급 자연어 처리 기술까지 다양한 알고리즘을 사용합니다.

주요 온라인 금칙어 검사 사이트 비교

다양한 금칙어 검사기 사이트들이 제공하는 기능과 특징을 비교해보겠습니다.

| 서비스명 | 주요 기능 | 언어 지원 | 가격 | 특징 |

|---|---|---|---|---|

| CleanSpeak | 실시간 필터링, API 제공 | 다국어 | 유료 | 게임/소셜미디어 특화 |

| WebPurify | 텍스트/이미지 필터링 | 30+ 언어 | 유료 | 이미지 콘텐츠 검사 |

| Perspective API | AI 기반 독성 탐지 | 영어 중심 | 무료/유료 | 구글 개발 |

| 한국형 필터링 도구 | 한국어 특화 | 한국어 | 무료/유료 | 한국 문화 반영 |

웹 금지어 검사 서비스를 선택할 때는 다음 요소들을 고려해야 합니다

성능 및 정확도

- 오탐지(False Positive) 및 미탐지(False Negative) 비율

- 처리 속도 및 응답 시간

- 문맥 이해 능력

기술적 요소:

- API 안정성 및 문서화 품질

- 다양한 프로그래밍 언어 SDK 지원

- 실시간 처리 성능

금칙어 필터링 알고리즘의 종류

[기본 키워드 매칭]

↓

[정규표현식 패턴]

↓

[유사도 기반 검사]

↓

[AI/ML 기반 분석]

↓

[문맥 인식 필터링]1. 기본 키워드 매칭

가장 단순한 형태의 필터링 알고리즘으로, 미리 정의된 금칙어 리스트와 입력 텍스트를 직접 비교합니다.

구현이 간단하고 빠른 처리가 가능하지만, 변형된 표현이나 우회 표현에 취약합니다.

2. 정규표현식 기반 필터링

정규표현식을 활용하여 패턴 기반의 더 유연한 검사를 수행합니다.

특수문자 삽입, 자음모음 분리, 유사 문자 치환 등의 우회 시도를 탐지할 수 있습니다.

3. 머신러닝 기반 접근법

자연어 처리 기술을 활용한 고급 필터링 방식입니다.

문맥을 이해하고 새로운 패턴을 학습할 수 있어 높은 정확도를 제공합니다.

파이썬으로 금칙어 검사기 구현하기

파이썬 예제를 통해 기본적인 금칙어 검사 시스템을 구현해보겠습니다.

기본 구현

import re

import json

from typing import List, Dict, Tuple

class ProfanityFilter:

def __init__(self, banned_words_file: str = None):

self.banned_words = set()

self.patterns = []

if banned_words_file:

self.load_banned_words(banned_words_file)

def load_banned_words(self, file_path: str):

"""금칙어 리스트를 파일에서 로드"""

try:

with open(file_path, 'r', encoding='utf-8') as f:

words = json.load(f)

self.banned_words.update(words)

self.compile_patterns()

except FileNotFoundError:

print(f"Warning: {file_path} not found")

def compile_patterns(self):

"""정규표현식 패턴 컴파일"""

self.patterns = []

for word in self.banned_words:

# 기본 패턴

pattern = re.compile(re.escape(word), re.IGNORECASE)

self.patterns.append(pattern)

# 변형 패턴 (특수문자 삽입 대응)

spaced_word = ''.join(f'{char}[^a-zA-Z가-힣]*' for char in word)

spaced_pattern = re.compile(spaced_word, re.IGNORECASE)

self.patterns.append(spaced_pattern)

def check_text(self, text: str) -> Dict:

"""텍스트에서 금칙어 검사 수행"""

found_words = []

cleaned_text = text

for pattern in self.patterns:

matches = pattern.finditer(text)

for match in matches:

found_words.append({

'word': match.group(),

'start': match.start(),

'end': match.end()

})

# 마스킹 처리

cleaned_text = cleaned_text[:match.start()] + '*' * len(match.group()) + cleaned_text[match.end():]

return {

'is_clean': len(found_words) == 0,

'found_words': found_words,

'cleaned_text': cleaned_text,

'severity_score': len(found_words)

}

# 사용 예제

filter_instance = ProfanityFilter('banned_words.json')

result = filter_instance.check_text("사용자 입력 텍스트")

print(f"검사 결과: {result}")고급 기능 추가

class AdvancedProfanityFilter(ProfanityFilter):

def __init__(self, banned_words_file: str = None):

super().__init__(banned_words_file)

self.whitelist = set()

self.severity_levels = {}

def add_severity_levels(self, severity_map: Dict[str, int]):

"""금칙어별 심각도 레벨 설정"""

self.severity_levels.update(severity_map)

def add_whitelist(self, words: List[str]):

"""화이트리스트 추가 (허용 단어)"""

self.whitelist.update(words)

def advanced_check(self, text: str) -> Dict:

"""고급 검사 기능"""

basic_result = self.check_text(text)

# 화이트리스트 확인

filtered_words = []

for found in basic_result['found_words']:

if found['word'].lower() not in self.whitelist:

severity = self.severity_levels.get(found['word'].lower(), 1)

found['severity'] = severity

filtered_words.append(found)

# 총 심각도 계산

total_severity = sum(word['severity'] for word in filtered_words)

return {

'is_clean': len(filtered_words) == 0,

'found_words': filtered_words,

'cleaned_text': basic_result['cleaned_text'],

'total_severity': total_severity,

'risk_level': self.get_risk_level(total_severity)

}

def get_risk_level(self, severity: int) -> str:

"""위험도 레벨 반환"""

if severity == 0:

return "안전"

elif severity <= 3:

return "낮음"

elif severity <= 7:

return "보통"

elif severity <= 15:

return "높음"

else:

return "매우 높음"자바스크립트 금칙어 필터 구현

클라이언트 사이드에서 동작하는 자바스크립트 구현 예제입니다.

기본 클라이언트 사이드 필터

class ClientProfanityFilter {

constructor(bannedWords = []) {

this.bannedWords = new Set(bannedWords.map(word => word.toLowerCase()));

this.patterns = this.compilePatterns();

}

compilePatterns() {

const patterns = [];

for (const word of this.bannedWords) {

// 기본 패턴

patterns.push(new RegExp(`\\b${this.escapeRegExp(word)}\\b`, 'gi'));

// 변형 패턴 (ㅏ → a, ㅓ → e 등)

const transformedWord = this.createTransformPattern(word);

if (transformedWord !== word) {

patterns.push(new RegExp(`\\b${transformedWord}\\b`, 'gi'));

}

}

return patterns;

}

escapeRegExp(string) {

return string.replace(/[.*+?^${}()|[\]\\]/g, '\\$&');

}

createTransformPattern(word) {

// 한국어 자모 분리 및 변형 패턴 생성

const transformMap = {

'ㅏ': '[ㅏa]',

'ㅓ': '[ㅓe]',

'ㅗ': '[ㅗo]',

'ㅜ': '[ㅜu]',

'ㅣ': '[ㅣi]'

};

let pattern = word;

for (const [korean, replacement] of Object.entries(transformMap)) {

pattern = pattern.replace(new RegExp(korean, 'g'), replacement);

}

return pattern;

}

checkText(text) {

const foundWords = [];

let cleanedText = text;

for (const pattern of this.patterns) {

const matches = text.matchAll(pattern);

for (const match of matches) {

foundWords.push({

word: match[0],

index: match.index,

length: match[0].length

});

// 마스킹 처리

const maskLength = match[0].length;

const replacement = '*'.repeat(maskLength);

cleanedText = cleanedText.substring(0, match.index) +

replacement +

cleanedText.substring(match.index + maskLength);

}

}

return {

isClean: foundWords.length === 0,

foundWords: foundWords,

cleanedText: cleanedText,

score: this.calculateRiskScore(foundWords)

};

}

calculateRiskScore(foundWords) {

return foundWords.length * 10; // 간단한 점수 계산

}

}

// 실시간 입력 검증 예제

document.getElementById('userInput').addEventListener('input', function(e) {

const filter = new ClientProfanityFilter(['금지어1', '금지어2']);

const result = filter.checkText(e.target.value);

const warningElement = document.getElementById('warning');

if (!result.isClean) {

warningElement.textContent = `부적절한 표현이 감지되었습니다: ${result.foundWords.length}개`;

warningElement.style.display = 'block';

} else {

warningElement.style.display = 'none';

}

});

서버 사이드 Node.js 구현

const express = require('express');

const app = express();

class ServerProfanityFilter {

constructor() {

this.bannedWords = new Map(); // word -> severity

this.loadBannedWords();

}

async loadBannedWords() {

// 데이터베이스나 파일에서 금칙어 로드

const words = {

'욕설1': 3,

'욕설2': 5,

'심각한욕설': 10

};

for (const [word, severity] of Object.entries(words)) {

this.bannedWords.set(word.toLowerCase(), severity);

}

}

async analyzeText(text) {

const results = {

isClean: true,

violations: [],

cleanedText: text,

riskScore: 0

};

for (const [word, severity] of this.bannedWords) {

const regex = new RegExp(`\\b${word}\\b`, 'gi');

const matches = [...text.matchAll(regex)];

if (matches.length > 0) {

results.isClean = false;

results.riskScore += severity * matches.length;

matches.forEach(match => {

results.violations.push({

word: match[0],

severity: severity,

position: match.index

});

});

// 텍스트 마스킹

results.cleanedText = results.cleanedText.replace(regex, '*'.repeat(word.length));

}

}

return results;

}

}

const filter = new ServerProfanityFilter();

app.post('/api/check-profanity', async (req, res) => {

try {

const { text } = req.body;

const result = await filter.analyzeText(text);

res.json({

success: true,

data: result

});

} catch (error) {

res.status(500).json({

success: false,

error: error.message

});

}

});

app.listen(3000, () => {

console.log('금칙어 검사 API 서버가 3000번 포트에서 실행 중입니다.');

});실시간 금칙어 검사 시스템 구축

실시간 필터링 시스템은 높은 성능과 확장성이 요구됩니다.

다음은 효율적인 시스템 설계 방법입니다.

시스템 아키텍처

[사용자 입력] → [클라이언트 사이드 필터] → [API Gateway]

↓

[로드 밸런서] → [필터링 서버 클러스터] → [캐시 레이어]

↓

[금칙어 DB] ← [관리자 인터페이스] ← [로그 및 분석]성능 최적화 전략

import asyncio

import aioredis

from typing import List

import hashlib

class OptimizedProfanityFilter:

def __init__(self):

self.redis = None

self.bloom_filter = None

self.trie_root = {}

async def initialize(self):

"""시스템 초기화"""

self.redis = await aioredis.create_redis_pool('redis://localhost')

await self.build_trie()

async def build_trie(self):

"""트라이 자료구조로 금칙어 저장"""

banned_words = await self.load_banned_words()

for word in banned_words:

current = self.trie_root

for char in word.lower():

if char not in current:

current[char] = {}

current = current[char]

current['$'] = True # 단어 끝 표시

async def quick_check(self, text: str) -> bool:

"""빠른 사전 검사 (Bloom Filter 활용)"""

text_hash = hashlib.md5(text.encode()).hexdigest()

cached_result = await self.redis.get(f"filter:{text_hash}")

if cached_result is not None:

return cached_result == b'clean'

# 트라이를 이용한 빠른 검사

words = text.lower().split()

for word in words:

if self.search_in_trie(word):

await self.redis.setex(f"filter:{text_hash}", 300, 'dirty')

return False

await self.redis.setex(f"filter:{text_hash}", 300, 'clean')

return True

def search_in_trie(self, word: str) -> bool:

"""트라이에서 단어 검색"""

current = self.trie_root

for char in word:

if char not in current:

return False

current = current[char]

return '$' in current

async def detailed_analysis(self, text: str) -> dict:

"""상세 분석 (필요시에만 실행)"""

if await self.quick_check(text):

return {'is_clean': True, 'details': []}

# 정밀 분석 수행

return await self.perform_deep_analysis(text)댓글 금칙어 시스템 통합

웹사이트나 애플리케이션에 금칙어 검사를 통합하는 방법을 알아보겠습니다.

WordPress 플러그인 통합

<?php

// WordPress 댓글 필터링 훅

add_filter('preprocess_comment', 'custom_profanity_filter');

function custom_profanity_filter($commentdata) {

$api_endpoint = 'https://your-api.com/check-profanity';

$comment_content = $commentdata['comment_content'];

$response = wp_remote_post($api_endpoint, array(

'body' => json_encode(array('text' => $comment_content)),

'headers' => array('Content-Type' => 'application/json')

));

if (!is_wp_error($response)) {

$result = json_decode(wp_remote_retrieve_body($response), true);

if (!$result['is_clean']) {

wp_die('댓글에 부적절한 표현이 포함되어 있습니다.');

}

// 자동 마스킹 옵션

if (get_option('auto_mask_profanity', false)) {

$commentdata['comment_content'] = $result['cleaned_text'];

}

}

return $commentdata;

}

?>React 컴포넌트 통합

import React, { useState, useEffect } from 'react';

const CommentBox = () => {

const [comment, setComment] = useState('');

const [warnings, setWarnings] = useState([]);

const [isChecking, setIsChecking] = useState(false);

useEffect(() => {

const timeoutId = setTimeout(() => {

if (comment.trim()) {

checkProfanity(comment);

}

}, 500); // 디바운싱

return () => clearTimeout(timeoutId);

}, [comment]);

const checkProfanity = async (text) => {

setIsChecking(true);

try {

const response = await fetch('/api/check-profanity', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

},

body: JSON.stringify({ text })

});

const result = await response.json();

if (!result.data.isClean) {

setWarnings(result.data.violations);

} else {

setWarnings([]);

}

} catch (error) {

console.error('금칙어 검사 오류:', error);

} finally {

setIsChecking(false);

}

};

const handleSubmit = async (e) => {

e.preventDefault();

if (warnings.length > 0) {

alert('부적절한 표현을 제거한 후 다시 시도해주세요.');

return;

}

// 댓글 제출 로직

console.log('댓글 제출:', comment);

};

return (

<div className="comment-box">

<form onSubmit={handleSubmit}>

<textarea

value={comment}

onChange={(e) => setComment(e.target.value)}

placeholder="댓글을 입력하세요..."

rows={4}

cols={50}

/>

{isChecking && <div className="checking">검사 중...</div>}

{warnings.length > 0 && (

<div className="warnings">

<p>⚠️ 다음 표현들을 확인해주세요:</p>

<ul>

{warnings.map((warning, index) => (

<li key={index}>

"{warning.word}" (위치: {warning.position})

</li>

))}

</ul>

</div>

)}

<button

type="submit"

disabled={warnings.length > 0 || isChecking}

className="submit-btn"

>

댓글 작성

</button>

</form>

</div>

);

};

export default CommentBox;금칙어 리스트 관리 전략

효과적인 금칙어 관리를 위한 체계적인 접근법을 소개합니다.

카테고리별 분류 시스템

class ProfanityManager:

def __init__(self):

self.categories = {

'profanity': {'severity': 5, 'action': 'block'},

'hate_speech': {'severity': 8, 'action': 'block'},

'spam': {'severity': 3, 'action': 'moderate'},

'adult_content': {'severity': 6, 'action': 'age_gate'},

'violence': {'severity': 7, 'action': 'block'}

}

self.word_database = {

'words': {},

'patterns': {},

'exceptions': set()

}

def add_word(self, word: str, category: str, custom_severity: int = None):

"""새로운 금칙어 추가"""

if category not in self.categories:

raise ValueError(f"Unknown category: {category}")

severity = custom_severity or self.categories[category]['severity']

self.word_database['words'][word.lower()] = {

'category': category,

'severity': severity,

'added_date': datetime.now(),

'usage_count': 0

}

def add_pattern(self, pattern: str, category: str):

"""정규표현식 패턴 추가"""

self.word_database['patterns'][pattern] = {

'category': category,

'compiled': re.compile(pattern, re.IGNORECASE)

}

def update_from_reports(self, user_reports: List[dict]):

"""사용자 신고 기반 업데이트"""

for report in user_reports:

word = report['word'].lower()

if word in self.word_database['words']:

# 기존 단어의 심각도 조정

current_severity = self.word_database['words'][word]['severity']

self.word_database['words'][word]['severity'] = min(10, current_severity + 1)

else:

# 새로운 단어 추가 (검토 대기)

self.add_word_for_review(word, report)

def export_word_list(self, format_type: str = 'json') -> str:

"""금칙어 리스트 내보내기"""

if format_type == 'json':

return json.dumps(self.word_database, indent=2, default=str)

elif format_type == 'csv':

# CSV 형태로 변환

import csv

import io

output = io.StringIO()

writer = csv.writer(output)

writer.writerow(['Word', 'Category', 'Severity', 'Added Date'])

for word, data in self.word_database['words'].items():

writer.writerow([word, data['category'], data['severity'], data['added_date']])

return output.getvalue()다국어 지원 시스템

class MultilingualProfanityFilter:

def __init__(self):

self.language_filters = {}

self.supported_languages = ['ko', 'en', 'ja', 'zh']

def load_language_data(self, language_code: str):

"""언어별 금칙어 데이터 로드"""

try:

with open(f'data/profanity_{language_code}.json', 'r', encoding='utf-8') as f:

data = json.load(f)

self.language_filters[language_code] = {

'words': set(data.get('words', [])),

'patterns': [re.compile(p, re.IGNORECASE) for p in data.get('patterns', [])],

'transformations': data.get('transformations', {})

}

except FileNotFoundError:

print(f"Language data for {language_code} not found")

def detect_language(self, text: str) -> str:

"""텍스트 언어 감지"""

# 간단한 휴리스틱 기반 언어 감지

korean_chars = len(re.findall(r'[가-힣]', text))

english_chars = len(re.findall(r'[a-zA-Z]', text))

total_chars = len(text.replace(' ', ''))

if total_chars == 0:

return 'unknown'

korean_ratio = korean_chars / total_chars

english_ratio = english_chars / total_chars

if korean_ratio > 0.3:

return 'ko'

elif english_ratio > 0.7:

return 'en'

else:

return 'mixed'

def check_multilingual_text(self, text: str) -> dict:

"""다국어 텍스트 검사"""

detected_language = self.detect_language(text)

results = {'detected_language': detected_language, 'violations': []}

# 감지된 언어의 필터 적용

if detected_language in self.language_filters:

lang_result = self.check_with_language_filter(text, detected_language)

results['violations'].extend(lang_result)

# 다국어 혼재 텍스트의 경우 모든 필터 적용

if detected_language == 'mixed':

for lang_code in self.supported_languages:

if lang_code in self.language_filters:

lang_result = self.check_with_language_filter(text, lang_code)

results['violations'].extend(lang_result)

return results

def check_with_language_filter(self, text: str, language: str) -> List[dict]:

"""특정 언어 필터로 검사"""

violations = []

filter_data = self.language_filters[language]

# 단어 기반 검사

words = text.lower().split()

for word in words:

if word in filter_data['words']:

violations.append({

'type': 'word',

'content': word,

'language': language,

'severity': 5

})

# 패턴 기반 검사

for pattern in filter_data['patterns']:

matches = pattern.finditer(text)

for match in matches:

violations.append({

'type': 'pattern',

'content': match.group(),

'language': language,

'position': match.start(),

'severity': 6

})

return violations사용자 입력 검증 모범 사례

안전하고 효과적인 사용자 입력 검증을 위한 모범 사례를 소개합니다.

계층적 필터링 전략

class LayeredInputValidator:

def __init__(self):

self.layers = [

('client_side', self.client_side_check),

('basic_filter', self.basic_profanity_filter),

('advanced_ai', self.ai_based_analysis),

('human_review', self.flag_for_human_review)

]

self.severity_thresholds = {

'auto_approve': 0,

'auto_moderate': 5,

'human_review': 8,

'auto_reject': 10

}

async def validate_input(self, text: str, user_context: dict) -> dict:

"""계층적 입력 검증 실행"""

result = {

'text': text,

'is_approved': False,

'action': 'pending',

'confidence': 0,

'layer_results': [],

'total_severity': 0

}

for layer_name, layer_func in self.layers:

layer_result = await layer_func(text, user_context)

result['layer_results'].append({

'layer': layer_name,

'result': layer_result

})

result['total_severity'] += layer_result.get('severity', 0)

# 조기 종료 조건

if layer_result.get('severity', 0) >= self.severity_thresholds['auto_reject']:

result['action'] = 'reject'

result['is_approved'] = False

break

# 최종 판정

if result['action'] == 'pending':

result['action'] = self.determine_final_action(result['total_severity'])

result['is_approved'] = result['action'] == 'approve'

return result

def determine_final_action(self, severity: int) -> str:

"""최종 액션 결정"""

if severity <= self.severity_thresholds['auto_approve']:

return 'approve'

elif severity <= self.severity_thresholds['auto_moderate']:

return 'moderate'

elif severity <= self.severity_thresholds['human_review']:

return 'review'

else:

return 'reject'

async def client_side_check(self, text: str, context: dict) -> dict:

"""클라이언트 사이드 기본 검사 결과 수신"""

# 실제로는 클라이언트에서 전송된 사전 검사 결과를 받음

return {'severity': 0, 'passed': True}

async def basic_profanity_filter(self, text: str, context: dict) -> dict:

"""기본 금칙어 필터"""

# 앞서 구현한 ProfanityFilter 사용

filter_instance = ProfanityFilter()

result = filter_instance.check_text(text)

return {

'severity': len(result['found_words']) * 2,

'violations': result['found_words'],

'cleaned_text': result['cleaned_text']

}

async def ai_based_analysis(self, text: str, context: dict) -> dict:

"""AI 기반 상세 분석"""

# 외부 AI 서비스 호출 (예: OpenAI Moderation API)

try:

# 실제 구현에서는 실제 AI 서비스 호출

ai_result = await self.call_ai_moderation_service(text)

return {

'severity': ai_result.get('severity_score', 0),

'categories': ai_result.get('flagged_categories', []),

'confidence': ai_result.get('confidence', 0)

}

except Exception as e:

return {'severity': 0, 'error': str(e)}

async def flag_for_human_review(self, text: str, context: dict) -> dict:

"""인간 검토 대기열에 추가"""

if context.get('requires_human_review', False):

# 검토 큐에 추가

await self.add_to_review_queue(text, context)

return {'severity': 0, 'queued_for_review': True}

return {'severity': 0, 'queued_for_review': False}실시간 모니터링 시스템

import asyncio

from datetime import datetime, timedelta

import logging

class RealTimeMonitoringSystem:

def __init__(self):

self.active_sessions = {}

self.violation_patterns = {}

self.alert_thresholds = {

'violations_per_minute': 10,

'unique_users_flagged': 5,

'severity_spike': 50

}

self.logger = logging.getLogger('profanity_monitor')

async def track_violation(self, user_id: str, violation_data: dict):

"""위반 사항 추적"""

timestamp = datetime.now()

# 사용자별 세션 추적

if user_id not in self.active_sessions:

self.active_sessions[user_id] = {

'violations': [],

'first_violation': timestamp,

'total_severity': 0

}

session = self.active_sessions[user_id]

session['violations'].append({

'timestamp': timestamp,

'data': violation_data,

'severity': violation_data.get('severity', 0)

})

session['total_severity'] += violation_data.get('severity', 0)

# 패턴 분석

await self.analyze_violation_patterns(user_id, violation_data)

# 실시간 알림 체크

await self.check_alert_conditions(user_id, session)

async def analyze_violation_patterns(self, user_id: str, violation: dict):

"""위반 패턴 분석"""

# 최근 1분간 위반 횟수 확인

recent_violations = await self.get_recent_violations(user_id, minutes=1)

if len(recent_violations) >= 5:

await self.trigger_rate_limit(user_id)

# 에스컬레이션 패턴 감지

if self.detect_escalation_pattern(recent_violations):

await self.escalate_user_monitoring(user_id)

async def get_recent_violations(self, user_id: str, minutes: int) -> List[dict]:

"""최근 위반 내역 조회"""

if user_id not in self.active_sessions:

return []

cutoff_time = datetime.now() - timedelta(minutes=minutes)

recent = [

v for v in self.active_sessions[user_id]['violations']

if v['timestamp'] > cutoff_time

]

return recent

def detect_escalation_pattern(self, violations: List[dict]) -> bool:

"""에스컬레이션 패턴 감지"""

if len(violations) < 3:

return False

# 심각도가 지속적으로 증가하는지 확인

severities = [v['data'].get('severity', 0) for v in violations[-3:]]

return all(severities[i] <= severities[i+1] for i in range(len(severities)-1))

async def trigger_rate_limit(self, user_id: str):

"""사용자 요청 제한 적용"""

self.logger.warning(f"Rate limit triggered for user: {user_id}")

# 실제 구현에서는 Redis 등을 사용한 rate limiting 적용

async def escalate_user_monitoring(self, user_id: str):

"""사용자 모니터링 강화"""

self.logger.critical(f"Escalated monitoring for user: {user_id}")

# 관리자 알림, 추가 검증 단계 적용 등운영 팁과 개발 노하우

실제 서비스 운영에서 얻은 경험을 바탕으로 한 실용적인 팁들을 공유합니다.

성능 최적화 기법

1. 캐싱 전략

import redis

from functools import wraps

def cache_result(expiry=300):

def decorator(func):

@wraps(func)

async def wrapper(*args, **kwargs):

# 캐시 키 생성

cache_key = f"filter:{hash(str(args) + str(kwargs))}"

# 캐시에서 조회

cached = await redis_client.get(cache_key)

if cached:

return json.loads(cached)

# 캐시 미스 시 실제 함수 실행

result = await func(*args, **kwargs)

# 결과 캐싱

await redis_client.setex(cache_key, expiry, json.dumps(result))

return result

return wrapper

return decorator

@cache_result(expiry=600)

async def expensive_ai_analysis(text: str) -> dict:

# 비용이 많이 드는 AI 분석

pass

2. 배치 처리 최적화

class BatchProfanityProcessor:

def __init__(self, batch_size=100):

self.batch_size = batch_size

self.pending_requests = []

async def add_request(self, text: str, callback):

"""요청을 배치에 추가"""

self.pending_requests.append({'text': text, 'callback': callback})

if len(self.pending_requests) >= self.batch_size:

await self.process_batch()

async def process_batch(self):

"""배치 처리 실행"""

if not self.pending_requests:

return

batch = self.pending_requests[:self.batch_size]

self.pending_requests = self.pending_requests[self.batch_size:]

# 배치 단위로 처리

texts = [req['text'] for req in batch]

results = await self.batch_filter_texts(texts)

# 결과를 각 요청의 콜백으로 전달

for i, result in enumerate(results):

await batch[i]['callback'](result)

async def batch_filter_texts(self, texts: List[str]) -> List[dict]:

"""여러 텍스트를 한 번에 처리"""

# 벡터화된 처리 로직

results = []

for text in texts:

# 실제로는 벡터화된 연산 사용

result = await self.single_text_analysis(text)

results.append(result)

return results데이터베이스 설계

-- 금칙어 관리 테이블

CREATE TABLE profanity_words (

id BIGINT PRIMARY KEY AUTO_INCREMENT,

word VARCHAR(255) NOT NULL,

category ENUM('profanity', 'hate_speech', 'spam', 'adult_content', 'violence'),

severity_level TINYINT NOT NULL DEFAULT 5,

language_code CHAR(2) NOT NULL DEFAULT 'ko',

is_pattern BOOLEAN DEFAULT FALSE,

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

updated_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,

created_by VARCHAR(255),

INDEX idx_word_lang (word, language_code),

INDEX idx_category (category),

INDEX idx_severity (severity_level)

);

-- 필터링 로그 테이블

CREATE TABLE filtering_logs (

id BIGINT PRIMARY KEY AUTO_INCREMENT,

user_id VARCHAR(255),

original_text TEXT,

filtered_text TEXT,

violations JSON,

severity_score INT,

action_taken ENUM('approved', 'rejected', 'moderated', 'reviewed'),

processing_time_ms INT,

ip_address VARCHAR(45),

user_agent TEXT,

timestamp TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

INDEX idx_user_id (user_id),

INDEX idx_timestamp (timestamp),

INDEX idx_action (action_taken),

INDEX idx_severity (severity_score)

);

-- 성능 통계 테이블

CREATE TABLE filter_performance_stats (

id BIGINT PRIMARY KEY AUTO_INCREMENT,

date_hour DATETIME,

total_requests INT DEFAULT 0,

blocked_requests INT DEFAULT 0,

avg_processing_time_ms DECIMAL(10,2),

false_positive_rate DECIMAL(5,4),

false_negative_rate DECIMAL(5,4),

UNIQUE KEY unique_hour (date_hour),

INDEX idx_date (date_hour)

);오픈소스 도구 및 라이브러리 활용

기존 오픈소스 솔루션을 활용한 효율적인 개발 방법을 소개합니다.

Python 라이브러리

# better-profanity 라이브러리 활용

from better_profanity import profanity

# 사용자 정의 금칙어 추가

profanity.add_censor_words(['새로운금칙어', '추가금칙어'])

# 검사 실행

text = "사용자 입력 텍스트"

is_clean = profanity.contains_profanity(text)

cleaned_text = profanity.censor(text)

# alt-profanity-check (다국어 지원)

from alt_profanity_check import predict

text = "Check this text for profanity"

probability = predict(text) # 0-1 사이의 확률값 반환JavaScript 라이브러리

// bad-words 라이브러리

const Filter = require('bad-words');

const filter = new Filter();

// 한국어 금칙어 추가

filter.addWords(['금칙어1', '금칙어2']);

// 검사 및 필터링

const hasProf = filter.isProfane('테스트 텍스트');

const cleaned = filter.clean('테스트 텍스트');

// leo-profanity (더 많은 기능)

const LeoProfanity = require('leo-profanity');

// 언어별 필터 로드

LeoProfanity.loadDictionary('ko'); // 한국어

LeoProfanity.loadDictionary('en'); // 영어

// 검사

const containsProf = LeoProfanity.check('텍스트');

const cleanedText = LeoProfanity.clean('텍스트');AI 기반 고급 필터링

머신러닝과 자연어 처리를 활용한 고급 필터링 기법을 알아보겠습니다.

Transformer 모델 활용

from transformers import pipeline, AutoTokenizer, AutoModelForSequenceClassification

import torch

class AIBasedModerationFilter:

def __init__(self):

# 한국어 혐오 표현 탐지 모델 로드

self.tokenizer = AutoTokenizer.from_pretrained('beomi/kcbert-base')

self.model = AutoModelForSequenceClassification.from_pretrained(

'hate-speech-detection-model' # 실제 모델 경로

)

# 영어 독성 탐지

self.toxicity_classifier = pipeline(

"text-classification",

model="unitary/toxic-bert"

)

async def analyze_text_sentiment(self, text: str) -> dict:

"""텍스트 감정 및 독성 분석"""

results = {

'toxicity_score': 0,

'hate_speech_probability': 0,

'categories': [],

'confidence': 0

}

try:

# 한국어 혐오 표현 분석

if self.contains_korean(text):

hate_result = await self.analyze_hate_speech_korean(text)

results.update(hate_result)

# 영어 독성 분석

if self.contains_english(text):

toxicity_result = self.toxicity_classifier(text)

results['toxicity_score'] = toxicity_result[0]['score']

# 종합 점수 계산

results['final_score'] = self.calculate_composite_score(results)

except Exception as e:

self.logger.error(f"AI analysis error: {e}")

results['error'] = str(e)

return results

async def analyze_hate_speech_korean(self, text: str) -> dict:

"""한국어 혐오 표현 분석"""

inputs = self.tokenizer(

text,

truncation=True,

padding=True,

max_length=512,

return_tensors="pt"

)

with torch.no_grad():

outputs = self.model(**inputs)

probabilities = torch.nn.functional.softmax(outputs.logits, dim=-1)

# 결과 해석 (0: 정상, 1: 혐오 표현)

hate_probability = probabilities[0][1].item()

return {

'hate_speech_probability': hate_probability,

'is_hate_speech': hate_probability > 0.7,

'confidence': max(probabilities[0]).item()

}

def contains_korean(self, text: str) -> bool:

"""한국어 포함 여부 확인"""

import re

return bool(re.search(r'[가-힣]', text))

def contains_english(self, text: str) -> bool:

"""영어 포함 여부 확인"""

import re

return bool(re.search(r'[a-zA-Z]', text))

def calculate_composite_score(self, results: dict) -> float:

"""종합 위험도 점수 계산"""

toxicity = results.get('toxicity_score', 0)

hate_speech = results.get('hate_speech_probability', 0)

# 가중 평균 계산

composite = (toxicity * 0.6) + (hate_speech * 0.4)

return min(1.0, composite)실시간 학습 시스템

class AdaptiveProfanityFilter:

def __init__(self):

self.model = self.load_base_model()

self.feedback_buffer = []

self.update_threshold = 100 # 피드백 100개마다 모델 업데이트

def add_feedback(self, text: str, is_profane: bool, confidence: float):

"""사용자 피드백 수집"""

self.feedback_buffer.append({

'text': text,

'label': is_profane,

'confidence': confidence,

'timestamp': datetime.now()

})

# 임계값 도달 시 모델 업데이트

if len(self.feedback_buffer) >= self.update_threshold:

asyncio.create_task(self.update_model())

async def update_model(self):

"""피드백 기반 모델 업데이트"""

try:

# 피드백 데이터를 학습 데이터로 변환

training_data = self.prepare_training_data(self.feedback_buffer)

# 온라인 학습 실행

await self.online_learning(training_data)

# 버퍼 초기화

self.feedback_buffer = []

self.logger.info("Model updated with new feedback data")

except Exception as e:

self.logger.error(f"Model update failed: {e}")

def prepare_training_data(self, feedback_data: List[dict]) -> dict:

"""피드백을 학습 데이터로 변환"""

texts = [item['text'] for item in feedback_data]

labels = [item['label'] for item in feedback_data]

weights = [item['confidence'] for item in feedback_data]

return {

'texts': texts,

'labels': labels,

'sample_weights': weights

}

async def online_learning(self, training_data: dict):

"""온라인 학습 실행"""

# 실제 구현에서는 적절한 온라인 학습 알고리즘 사용

# 예: SGD, Adam optimizer 등

pass결론 및 향후 전망

금칙어 검사기와 온라인 필터링 시스템은 안전한 디지털 환경 구축의 핵심 요소입니다.

기본적인 키워드 매칭부터 AI 기반 고급 분석까지 다양한 접근 방식을 통해 효과적인 콘텐츠 필터링을 구현할 수 있습니다.

핵심 성공 요소

- 다층적 접근: 클라이언트와 서버 사이드 필터링을 조합한 보안 강화

- 실시간 처리: 사용자 경험을 해치지 않는 빠른 응답 시간 확보

- 지속적 개선: 피드백 기반 시스템 업데이트와 새로운 패턴 학습

- 문화적 고려: 지역별, 언어별 특성을 반영한 맞춤형 필터링

미래 발전 방향

향후에는 더욱 정교한 문맥 이해 능력을 갖춘 AI 모델과 실시간 학습이 가능한 적응형 시스템이 주류가 될 것으로 예상됩니다.

또한 개인화된 필터링 설정과 투명한 검열 과정을 통해 사용자 신뢰도를 높이는 방향으로 발전할 것입니다.

웹 서비스 필터링 기술은 계속해서 진화하고 있으며, 개발자들은 최신 트렌드와 기술을 지속적으로 학습하여 더 나은 온라인 환경을 만들어나가야 합니다.

효과적인 금칙어 검사 알고리즘과 실시간 필터링 시스템을 구축하여 건전한 디지털 커뮤니티를 만들어보시기 바랍니다.

참고 자료

같이 읽으면 좋은 글

GPT-5 사용법: OpenAI 공식 가이드 기반의 활용 방법과 실전 팁

OpenAI에서 2025년 8월 7일 공식 출시한 GPT-5는 기존 GPT-4 시리즈와 o-시리즈 추론 모델을 통합한 차세대 AI 모델로, 자동 라우팅 시스템을 통해 사용자가 모델을 선택할 필요 없이 최적의 응답을 제공

notavoid.tistory.com

Claude Opus 4.1: 에이전트 작업, 실전 코딩, 추론 능력이 대폭 강화된 최신 AI 모델 출시 소식 및 주요

Claude Opus 4.1이 출시되며 SWE-bench에서 74.5%의 성능을 달성하여 실전 코딩과 에이전트 작업 능력이 대폭 향상되었습니다.2025년 8월 5일, Anthropic에서 Claude Opus 4.1 업데이트를 발표했습니다.이번 업데

notavoid.tistory.com

Qwen3 Coder: 최신 AI 코딩 모델 특징, 성능 비교 및 실전 활용 가이드

Qwen3-Coder는 2025년 7월 출시된 알리바바의 최신 AI 코딩 모델로, 480B 파라미터의 Mixture-of-Experts 아키텍처를 통해 Claude Sonnet 4와 GPT-4.1에 필적하는 성능을 제공하며, SWE-bench Verified에서 69.6%의 검증된

notavoid.tistory.com

'유용한툴 및 사이트' 카테고리의 다른 글

| imoova(이무바)란? 일본 여행자를 위한 저렴한 차량·캠핑카 이동 서비스 총정리 (0) | 2025.08.06 |

|---|---|

| VirtualBox: 설치부터 Headless Frontend 운용, 공유폴더 설정까지 실전 가이드 (1) | 2025.07.26 |

| Supabase vs Firebase: 2025년 실시간 백엔드 서비스 비교와 선택 가이드 (0) | 2025.07.20 |

| PlanetScale vs Supabase: 2025년 MySQL & PostgreSQL 클라우드 DB 서비스 완전 비교 (0) | 2025.07.20 |

| Postman vs Insomnia: 2025년 최고의 API 테스트 툴 비교 및 선택 가이드 (0) | 2025.07.20 |