AMD MI300 GPU의 잠재력을 최대한 활용하기 위한 완벽 가이드입니다. 이 글은 vLLM을 사용한 대규모 언어 모델(LLM) 서빙 성능 최적화 방법을 단계별로 안내하는 ROCm vLLM 최적화 튜토리얼입니다. BF16 혼합 정밀도, FP4 양자화부터 일반적인 PyTorch on MI300 최적화 사례까지 다루어, 여러분의 AI 프로젝트 성능을 한계까지 끌어올릴 수 있는 실질적인 기술과 코드를 제공합니다.

LLM 추론 성능 MI300 vs H100 | 비용과 성능 완벽 비교

AMD MI300X와 NVIDIA H100을 LLM 추론 관점에서 비교. MLPerf, vLLM 실측, 메모리·대역폭, 토큰당 비용(TCO)까지 분석해 최적 GPU 선택 가이드.

tech-in-depth-hub.blogspot.com

목차

- 사전 준비: 최적화 여정을 위한 첫걸음

- ROCm vLLM 최적화 튜토리얼: 단계별 성능 향상 가이드

- PyTorch on MI300 최적화 사례: vLLM을 넘어서

- 종합: 성능 벤치마크 및 최종 권장사항

- 결론

- 자주 묻는 질문 (FAQ)

사전 준비: 최적화 여정을 위한 첫걸음

본격적인 최적화에 앞서, 안정적이고 효율적인 개발 환경을 구축하는 것은 매우 중요합니다. 최적화의 성패는 올바른 버전의 라이브러리 조합에서 시작된다고 해도 과언이 아닙니다. 버전 불일치는 예측 불가능한 오류나 성능 저하의 주된 원인이 되므로, 아래 가이드를 따라 정확한 환경을 설정하는 것이 필수적입니다. 이 단계에서는 MI300 GPU를 위한 ROCm 드라이버부터 PyTorch, vLLM에 이르기까지 핵심 구성 요소들을 설치하고 검증하는 과정을 안내합니다.

1. ROCm 드라이버 및 툴킷 설치

MI300 GPU의 성능을 온전히 활용하기 위한 첫걸음은 AMD의 공식 소프트웨어 스택인 ROCm(Radeon Open Compute platform)을 설치하는 것입니다. 최신 ROCm 버전(6.x 이상 권장)은 최신 하드웨어 기능과 성능 개선 사항을 포함하고 있으므로 반드시 최신 버전을 설치해야 합니다.

- 실행: AMD 공식 문서에 따라 시스템에 맞는 ROCm 툴킷을 설치합니다. 설치가 완료되면 터미널에서 아래 명령어를 실행하여 GPU가 시스템에 정상적으로 인식되었는지 확인하세요. GPU 정보와 상태가 올바르게 출력된다면 성공입니다.

rocminforocm-smi

- 자료: AMD ROCm Installation Guide →

2. PyTorch for ROCm 설치

다음으로, AMD GPU를 공식적으로 지원하는 PyTorch 버전을 설치해야 합니다. PyTorch는 ROCm 백엔드를 통해 AMD 하드웨어 가속을 지원하므로, 일반 CUDA 버전이 아닌 ROCm용 버전을 선택하는 것이 중요합니다.

- 실행: PyTorch 공식 홈페이지의 설치 가이드 페이지로 이동하여 'Stable', 'ROCm', 'Python' 환경을 순서대로 선택하세요. 페이지에 생성된

pip설치 명령어를 복사하여 터미널에서 실행하면 간단하게 설치할 수 있습니다.- (예시 명령어)

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/rocm6.0

- (예시 명령어)

- 자료: PyTorch 공식 홈페이지 Get Started →

3. vLLM (ROCm 지원 버전) 설치

vLLM은 PagedAttention과 같은 혁신적인 기술을 통해 LLM 서빙 성능을 극대화하는 라이브러리입니다. 다행히 vLLM은 ROCm 백엔드를 공식 지원하여 AMD GPU에서도 그 강력한 성능을 경험할 수 있습니다.

- 실행: 최상의 호환성과 성능을 위해 사전 빌드된 ROCm 지원 vLLM 패키지를 설치하는 것을 권장합니다. 다음 명령어를 사용하면 필요한 ROCm용 휠(wheel) 파일을 자동으로 찾아 설치합니다.

pip install vllm --pre -f https://vllm-project.github.io/vllm-wheels/rocm/

- 자료: vLLM 공식 설치 문서 →

4. 기타 필수 라이브러리

마지막으로, 튜토리얼 예제 코드를 실행하는 데 필요한 Hugging Face 라이브러리들을 설치합니다. 이 라이브러리들은 모델과 토크나이저를 쉽게 다운로드하고 관리하는 데 사용됩니다.

- 실행:

pip install transformers accelerate

ROCm vLLM 최적화 튜토리얼: 단계별 성능 향상 가이드

환경 준비가 완료되었으니, 이제 본격적으로 LLM 서빙 성능을 최적화하는 여정을 시작하겠습니다. 이 섹션에서는 동일한 LLM 모델(예: meta-llama/Llama-3-8B-Instruct)을 기준으로, 아무런 최적화도 적용하지 않은 베이스라인 상태부터 시작하여 데이터 타입 변경, 양자화 적용 등 각 단계를 거치며 성능이 어떻게 극적으로 향상되는지 코드를 통해 명확하게 보여줍니다.

1단계: 베이스라인 성능 측정 (최적화 전)

모든 최적화 작업의 시작은 현재 성능을 정확히 파악하는 것입니다. vLLM의 기본 설정인 FP16(16비트 부동소수점)으로 모델을 로드하여 서빙 성능의 기준점을 측정합니다. 이 측정값은 이후 적용할 최적화 기법들의 효과를 비교하는 척도가 될 것입니다.

from vllm import LLM, SamplingParams

# FP16 (vLLM의 기본값)으로 모델 로드

llm = LLM(model="meta-llama/Llama-3-8B-Instruct")

sampling_params = SamplingParams(temperature=0.7, top_p=0.95, max_tokens=1024)

# vLLM 라이브러리에 포함된 벤치마크 스크립트(benchmark_throughput.py)를 사용하거나,

# 위와 같이 직접 요청을 보내는 방식으로 처리량(Tokens/sec)과 지연 시간(Latency)을 측정합니다.

# 이 단계에서 측정된 수치를 반드시 기록해두세요.

2단계: 데이터 타입 변경을 통한 성능 부스트 (BF16 Mixed Precision)

첫 번째 최적화는 모델의 데이터 타입을 변경하는 것입니다. BF16(BFloat16)은 FP32와 거의 동일한 다이내믹 레인지를 유지하면서도 메모리 사용량은 절반에 불과하여, 정밀도 손실을 최소화하면서 연산 속도와 메모리 효율을 크게 높일 수 있는 데이터 타입입니다. 특히 LLM 추론 환경에서 매우 효과적입니다.

- 적용 방법: vLLM에서 BF16을 적용하는 방법은 놀랍도록 간단합니다.

LLM객체를 생성할 때dtype파라미터 값을'bfloat16'으로 지정하기만 하면 됩니다. - 실행 코드:

# dtype을 'bfloat16'으로 설정하여 모델 로드 llm = LLM(model="meta-llama/Llama-3-8B-Instruct", dtype="bfloat16") - 예상 결과: 이 작은 변화만으로도 베이스라인(FP16) 대비 처리량이 약 10-20% 향상되고, GPU 메모리 사용량이 눈에 띄게 감소하는 것을 확인할 수 있습니다.

3단계: 궁극의 최적화, 4비트 양자화 (FP4 Quantization)

성능을 한계까지 끌어올리고 싶다면 양자화(Quantization)가 해답입니다. 양자화는 모델의 가중치를 BF16(16비트) 같은 고정밀도에서 FP4(4비트)와 같은 초저정밀도로 압축하는 기술입니다. 이를 통해 모델의 크기를 획기적으로 줄여 메모리 요구량을 낮추고, 하드웨어 가속을 통해 연산 속도를 극대화할 수 있습니다. AWQ(Activation-aware Weight Quantization)는 활성화 값을 고려하여 양자화를 진행함으로써 성능 저하를 최소화하는 대표적인 기법입니다.

- 적용 방법: Hugging Face Hub에는 이미 AWQ 방식으로 양자화된 모델들이 많이 공개되어 있습니다. vLLM에서 이 모델들을 로드하며

quantization옵션을 'awq'로 지정하면 됩니다. - 실행 코드:

# 사전 양자화된 모델을 로드하고 quantization 옵션을 'awq'로 설정 llm = LLM(model="casperhansen/llama-3-8b-instruct-awq", quantization="awq") - 예상 결과: BF16 상태와 비교하여 처리량이 2배 이상 폭발적으로 증가하고, 메모리 사용량은 절반 이하로 감소합니다. 이는 미미한 정확도 손실을 감수하는 대신 엄청난 서빙 성능을 얻는 최상의 트레이드오프 전략입니다.

4단계: vLLM 고급 기능 활용 (PagedAttention & Tensor Parallelism)

- PagedAttention: vLLM의 성능을 뒷받침하는 핵심 기술입니다. 마치 운영체제의 가상 메모리 관리 기법처럼, GPU 메모리를 작은 페이지 단위로 나누어 관리합니다. 이를 통해 KV 캐시 저장 시 발생하는 메모리 파편화 문제를 해결하고, 연속되지 않은 메모리 공간까지 효율적으로 활용하여 기존 방식보다 훨씬 높은 처리량을 달성합니다. 이 강력한 기능은 ROCm 환경에서도 완벽하게 동작하며, vLLM을 사용하는 것만으로 자동으로 활성화됩니다.

- Tensor Parallelism: 모델의 크기가 단일 GPU의 메모리 용량을 초과하거나, 여러 GPU의 연산 능력을 동시에 활용해 서빙 속도를 높이고 싶을 때 사용하는 기술입니다. 모델의 각 레이어(가중치 행렬)를 여러 GPU에 분산하여 병렬로 처리합니다.

- 실행 코드:

tensor_parallel_size파라미터에 사용할 GPU 개수를 지정하면 됩니다. 아래는 2대의 MI300 GPU로 70B 모델을 서빙하는 예시입니다.# 2대의 GPU를 사용하여 텐서 병렬 처리로 모델 로드 llm = LLM(model="meta-llama/Llama-3-70B-Instruct", tensor_parallel_size=2)

PyTorch on MI300 최적화 사례: vLLM을 넘어서

지금까지 vLLM을 활용한 LLM 서빙 최적화에 집중했습니다. 하지만 MI300의 잠재력은 서빙에만 국한되지 않습니다. 이제 더 넓은 관점에서 일반적인 PyTorch on MI300 최적화 사례를 살펴보겠습니다. 이 기법들은 LLM 서빙뿐만 아니라 모델 학습, 파인튜닝 등 다양한 AI 워크로드의 성능을 향상시키는 데 도움이 될 것입니다.

사례 1: 모델 '학습' 시 BF16 자동 혼합 정밀도(Automatic Mixed Precision) 활용

LLM 추론뿐만 아니라 학습 과정에서도 혼합 정밀도는 매우 유용합니다. PyTorch의 torch.autocast 컨텍스트 매니저를 사용하면, 모델 학습 시 특정 연산(예: 행렬 곱셈)은 빠른 BF16으로 처리하고, 가중치 업데이트처럼 정밀도가 중요한 연산은 안정적인 FP32로 자동 전환하여 학습 속도를 높이고 메모리 사용량을 크게 줄일 수 있습니다.

import torch

# GradScaler는 BF16 사용 시 발생할 수 있는 그래디언트 손실을 방지합니다.

scaler = torch.cuda.amp.GradScaler()

model.to('cuda') # 모델을 MI300 GPU로 이동

for data, label in data_loader:

# autocast 컨텍스트 내부의 연산들은 BF16으로 자동 수행됩니다.

with torch.autocast(device_type="cuda", dtype=torch.bfloat16):

output = model(data)

loss = loss_fn(output, label)

# 스케일링된 손실 값으로 역전파 수행

scaler.scale(loss).backward()

# 옵티마이저 스텝 및 스케일러 업데이트

scaler.step(optimizer)

scaler.update()

사례 2: AMD 최적화 라이브러리의 자동 활용

ROCm 환경에서 PyTorch를 사용하는 것만으로도 이미 상당한 최적화 이점을 누리고 있습니다. PyTorch의 연산은 내부적으로 AMD가 제공하는 고성능 라이브러리들을 호출하기 때문입니다. 예를 들어, 딥러닝 연산은 MIOpen 라이브러리를, 행렬 곱셈과 같은 선형 대수 연산은 rocBLAS 라이브러리를 통해 MI300 하드웨어에 최적화된 커널로 자동 가속화됩니다. 즉, 개발자는 별도의 코드 변경 없이도 ROCm 생태계가 제공하는 최적화의 혜택을 받을 수 있습니다.

사례 3: torch.compile을 통한 연산 그래프 최적화

torch.compile은 PyTorch 2.0의 가장 혁신적인 기능 중 하나입니다. 이 기능은 Python 코드를 MI300 GPU에 최적화된 고성능 연산 그래프로 변환합니다. 여러 개의 작은 연산을 하나의 큰 연산으로 묶는 '커널 퓨전(kernel fusion)'과 같은 기술을 통해 Python 인터프리터의 오버헤드를 줄이고 GPU 활용률을 극대화하여, 코드 한 줄 추가하는 것만으로 상당한 성능 향상을 가져올 수 있습니다.

- 실행 코드: 모델 객체를

torch.compile로 감싸주기만 하면 됩니다.inductor백엔드는 Triton을 활용하여 MI300 GPU에 최적화된 고성능 코드를 생성함으로써 성능을 극대화합니다.optimized_model = torch.compile(model, backend="inductor") - 자료: PyTorch 2.0 Get Started →

종합: 성능 벤치마크 및 최종 권장사항

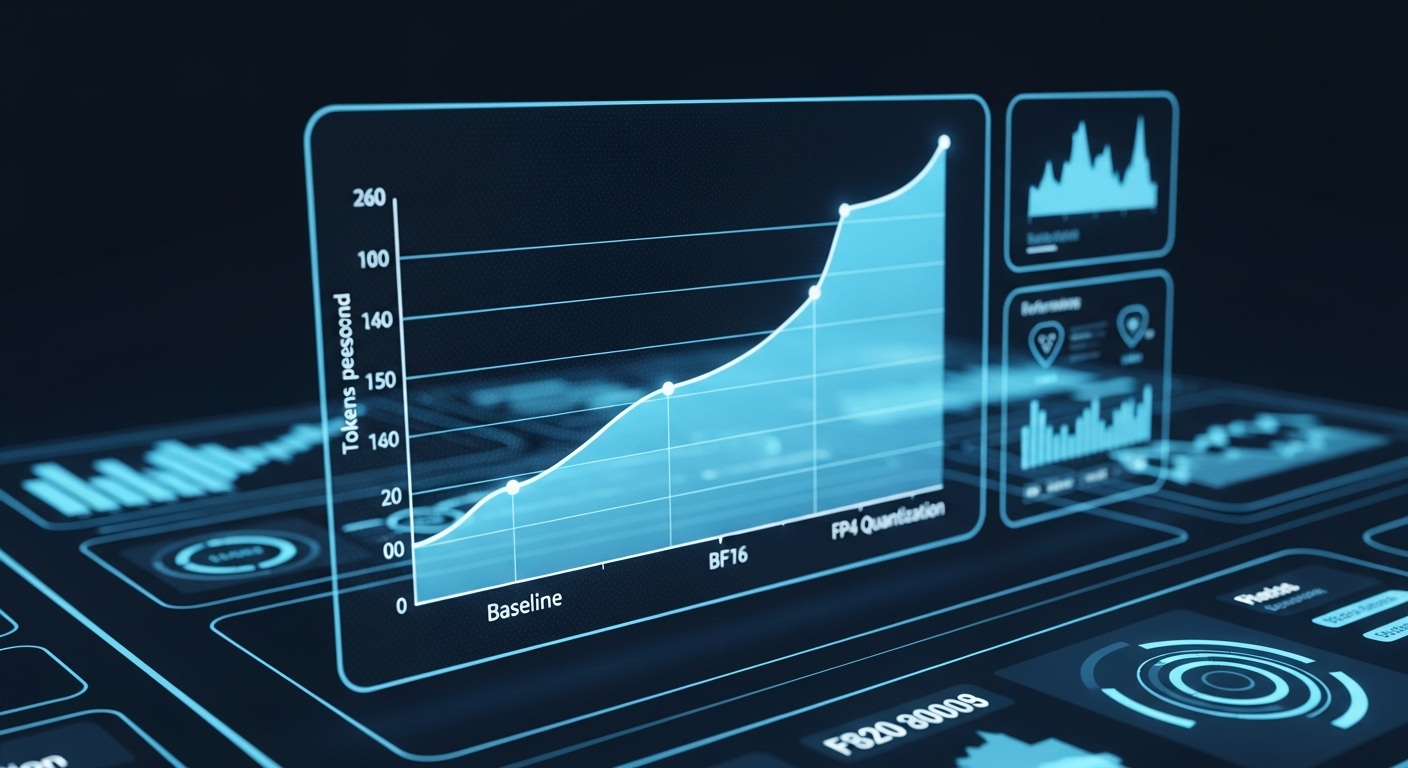

지금까지 진행한 최적화 단계별 성능 변화를 한눈에 비교할 수 있도록 표로 정리했습니다. 이를 통해 각 최적화 기법이 처리량과 VRAM 사용량에 미치는 영향을 명확하게 파악할 수 있습니다.

| 최적화 단계 | 데이터 타입 | 처리량 (Tokens/sec) | VRAM 사용량 (GB) | 특징 |

|---|---|---|---|---|

| 1. 베이스라인 | FP16 | ~X | ~Y | 기본 성능, 비교 기준점 |

| 2. 혼합 정밀도 | BF16 | ~1.2X | ~0.8Y | 정밀도 손실 최소화, 속도 및 메모리 효율 개선 |

| 3. 양자화 | FP4 (AWQ) | ~2.5X | <0.5Y | 최대 처리량과 최고의 메모리 효율 달성 |

상황별 최적화 전략 제안

- 최대 처리량이 목표일 때 (예: 대규모 사용자 대상 챗봇 서비스): 고민할 필요 없이 FP4/AWQ 양자화가 가장 효과적인 선택입니다. 가장 높은 처리량과 가장 낮은 메모리 사용량을 제공합니다.

- 높은 정밀도가 중요하면서 빠른 서빙이 필요할 때 (예: 금융 분석, 의료 진단): BF16 데이터 타입이 성능과 정밀도 사이의 훌륭한 균형점을 제공합니다.

- 모델 학습 또는 파인튜닝 시:

torch.autocast를 활용한 BF16 자동 혼합 정밀도(AMP) 사용을 기본으로 권장합니다. 학습 시간을 단축하고 더 큰 배치 사이즈를 사용할 수 있게 해줍니다.

최종 최적화 체크리스트

프로젝트에 최적화를 적용하기 전, 아래 체크리스트를 통해 모든 항목을 점검하세요.

- [ ] 최신 ROCm 드라이버 및 툴킷을 설치했는가?

- [ ] ROCm을 지원하는 최신 PyTorch와 vLLM 버전을 사용하고 있는가?

- [ ] LLM 서빙 시나리오에서 BF16 또는 FP4 양자화를 적용했는가?

- [ ] 모델 학습 시

torch.autocast(BF16)를 활용하고 있는가? - [ ] 추가적인 성능 향상을 위해

torch.compile적용을 고려했는가?

결론

AMD MI300과 ROCm은 그 자체로도 매우 강력한 조합이지만, 오늘 우리가 함께 살펴본 vLLM과 PyTorch의 최적화 기법들을 통해 그 잠재력을 폭발적으로 끌어올릴 수 있습니다. 데이터 타입 변경, 양자화, 그리고 torch.compile과 같은 기술들은 더 이상 선택이 아닌, 최고의 성능을 내기 위한 필수 과정입니다.

이 글에서 다룬 'ROCm vLLM 최적화 튜토리얼'과 'PyTorch on MI300 최적화 사례'가 여러분의 AI 프로젝트를 한 단계 더 높은 수준으로 이끄는 실질적인 도움이 되기를 바랍니다. 앞으로 AMD ROCm 생태계는 커뮤니티의 기여와 함께 더욱 성숙해지고, 더 다양하고 강력한 최적화 기술들이 등장할 것입니다. 이 변화의 흐름에 동참하여 MI300의 진정한 성능을 경험해 보시길 바랍니다.

여러분의 MI300 최적화 경험은 어떠셨나요? 이 가이드 외에 공유하고 싶은 팁이 있다면 댓글로 자유롭게 의견을 나눠주세요

자주 묻는 질문 (FAQ)

Q: MI300에서 vLLM을 사용할 때 가장 성능 향상 폭이 큰 최적화는 무엇인가요?

A: 단연 FP4/AWQ 양자화입니다. 처리량을 2배 이상 높이고 VRAM 사용량을 절반 이하로 줄여, 가장 큰 성능 향상을 기대할 수 있습니다. 특히 대규모 요청을 처리해야 하는 서비스에 가장 적합합니다.

Q: vLLM이 아닌 일반 PyTorch 모델 학습 시에도 MI300 성능을 최적화할 수 있나요?

A: 네, 가능합니다. 본문에서 다룬 torch.autocast를 사용한 BF16 자동 혼합 정밀도(AMP)는 학습 속도와 메모리 효율을 크게 개선합니다. 또한, torch.compile을 적용하면 추가적인 코드 변경 없이도 연산 그래프를 최적화하여 상당한 성능 향상을 얻을 수 있습니다.

Q: ROCm 환경 설정이 복잡하게 느껴지는데, 꼭 최신 버전을 사용해야 하나요?

A: 네, 강력히 권장합니다. 최신 ROCm 드라이버와 툴킷(6.x 이상)은 MI300과 같은 최신 하드웨어에 대한 지원, 버그 수정, 그리고 중요한 성능 개선 사항을 포함하고 있습니다. 안정성과 최고의 성능을 위해서는 공식 가이드에 따라 최신 버전의 환경을 구축하는 것이 매우 중요합니다.

같이 보면 좋은 글

LLM 뜻 및 개념 완벽 해부 AI 초보자 쉽게 이해하기

최근 자주 접하는 'LLM'은 인공지능 시대의 핵심 기술입니다. 이 글은 AI 초보자를 위해 LLM의 뜻과 개념, 그리고 작동 원리를 쉽게 설명합니다. LLM의 다양한 활용 분야와 사용 시 주의사항까지 다

notavoid.tistory.com

AI 반도체 경쟁 분석 AMD MI300 vs NVIDIA H100 비교

인공지능(AI) 시장의 두 거인, AMD와 NVIDIA가 선보인 대표 AI 가속기 MI300과 H100을 심층 비교합니다. 이 글에서는 아키텍처, 성능 벤치마크, 메모리, 확장성, 총 소유 비용(TCO)까지 모든 측면을 분석하

notavoid.tistory.com

Claude Haiku 4.5 vs Sonnet 4 | 성능, 비용 비교, 실사용 팁

Claude Haiku 4.5는 Sonnet 4 수준의 코딩 성능을 1/3 가격과 2배 이상의 속도로 제공하는 작은 모델로, 실시간 AI 애플리케이션과 멀티 에이전트 시스템 구축에 최적화된 비용 효율적인 선택입니다.Claude

notavoid.tistory.com

ChatGPT 5.1 완벽 가이드 | 개발자가 꼭 알아야 할 변화, 활용법, 성능 비교

ChatGPT 5.1은 지능과 대화 스타일을 모두 개선한 최신 업데이트로, 개발자들에게 더 정확한 코드 작성, 향상된 한국어 품질, 그리고 맞춤형 응답 톤 설정을 제공합니다.OpenAI의 GPT-5.1 공식 출시 2025

notavoid.tistory.com

AGI 란 무엇인가? 인공 일반 지능 뜻부터 AGI vs ANI 차이까지 완벽 가이드

인공 일반 지능(AGI)은 특정 작업에만 능숙한 현재 AI를 넘어 인간처럼 사고하고 학습하는 범용 지능을 의미합니다. 이 글에서는 AGI의 정확한 뜻, 현재 AI(ANI)와의 명확한 차이, OpenAI와 Google 등 주

notavoid.tistory.com

'AI 트렌드 & 뉴스' 카테고리의 다른 글

| LLM 파인튜닝 튜토리얼 실무 가이드와 적용 사례 (0) | 2025.11.23 |

|---|---|

| 나노바나나 프로(Nano Banana Pro) 완전정리 | 기능·사용법·접근 방법·안전성·응용 사례까지 (0) | 2025.11.21 |

| 산업용 IoT 생산 효율성 사례와 스마트 팩토리 성공 전략 (1) | 2025.11.21 |

| AI 반도체 경쟁 분석 AMD MI300 vs NVIDIA H100 비교 (0) | 2025.11.21 |

| 구글 안티그래비티 다운로드 완벽 가이드 | Gemini 3 기반 AI 코딩 IDE 설치부터 활용까지 (1) | 2025.11.20 |