현대 개발 환경에서 컨테이너 기술은 필수적인 요소가 되었습니다.

하지만 Docker의 무거운 가상화 오버헤드와 복잡한 설정 과정에 지친 개발자들이 늘어나고 있습니다.

이제 WebAssembly WASI(WebAssembly System Interface)라는 혁신적인 기술을 통해

Docker 없이도 효율적인 서버사이드 개발이 가능해졌습니다.

WASI는 WebAssembly의 서버사이드 확장으로, 기존 컨테이너 기술의 한계를 뛰어넘는 새로운 패러다임을 제시하고 있습니다.

WebAssembly WASI란 무엇인가?

WebAssembly System Interface(WASI)는 WebAssembly 모듈이 운영 체제와

상호작용할 수 있도록 하는 표준화된 인터페이스입니다.

기존 WebAssembly가 브라우저 환경에 국한되었다면,

WASI는 서버 환경에서도 WebAssembly를 활용할 수 있게 해주는 핵심 기술입니다.

WASI의 가장 큰 특징은 '보안성'과 '휴대성'입니다.

샌드박스 환경에서 실행되어 보안이 강화되며, 한 번 컴파일된 WebAssembly 모듈은 어떤 플랫폼에서든 동일하게 작동합니다.

이는 "Write Once, Run Anywhere"라는 개발자들의 오랜 꿈을 현실로 만들어주는 혁신적인 기술입니다.

Docker와 달리 운영 체제 수준의 가상화가 아닌,

바이트코드 수준에서의 추상화를 통해 더 가벼우면서도 효율적인 실행 환경을 제공합니다.

Docker vs WASI: 성능과 효율성 비교

기존 Docker 컨테이너와 WASI 기반 애플리케이션의 차이점을 살펴보면 놀라운 성능 차이를 확인할 수 있습니다.

Docker는 Linux 네임스페이스와 cgroups를 사용하여 프로세스를 격리하는 반면, WASI는 WebAssembly의 샌드박스 모델을 활용합니다.

메모리 사용량 비교

일반적인 Node.js 애플리케이션을 예로 들면:

- Docker 컨테이너: 기본 100-200MB + 애플리케이션 메모리

- WASI 런타임: 기본 10-30MB + 애플리케이션 메모리

시작 시간 비교

컨테이너 시작 시간에서도 현저한 차이를 보입니다:

- Docker 컨테이너: 평균 2-5초

- WASI 애플리케이션: 평균 50-200ms

이러한 성능 차이는 마이크로서비스 아키텍처나 서버리스 환경에서 특히 중요한 의미를 갖습니다.

빠른 콜드 스타트가 필요한 FaaS(Function as a Service) 환경에서 WASI는 Docker보다 훨씬 우수한 성능을 보여줍니다.

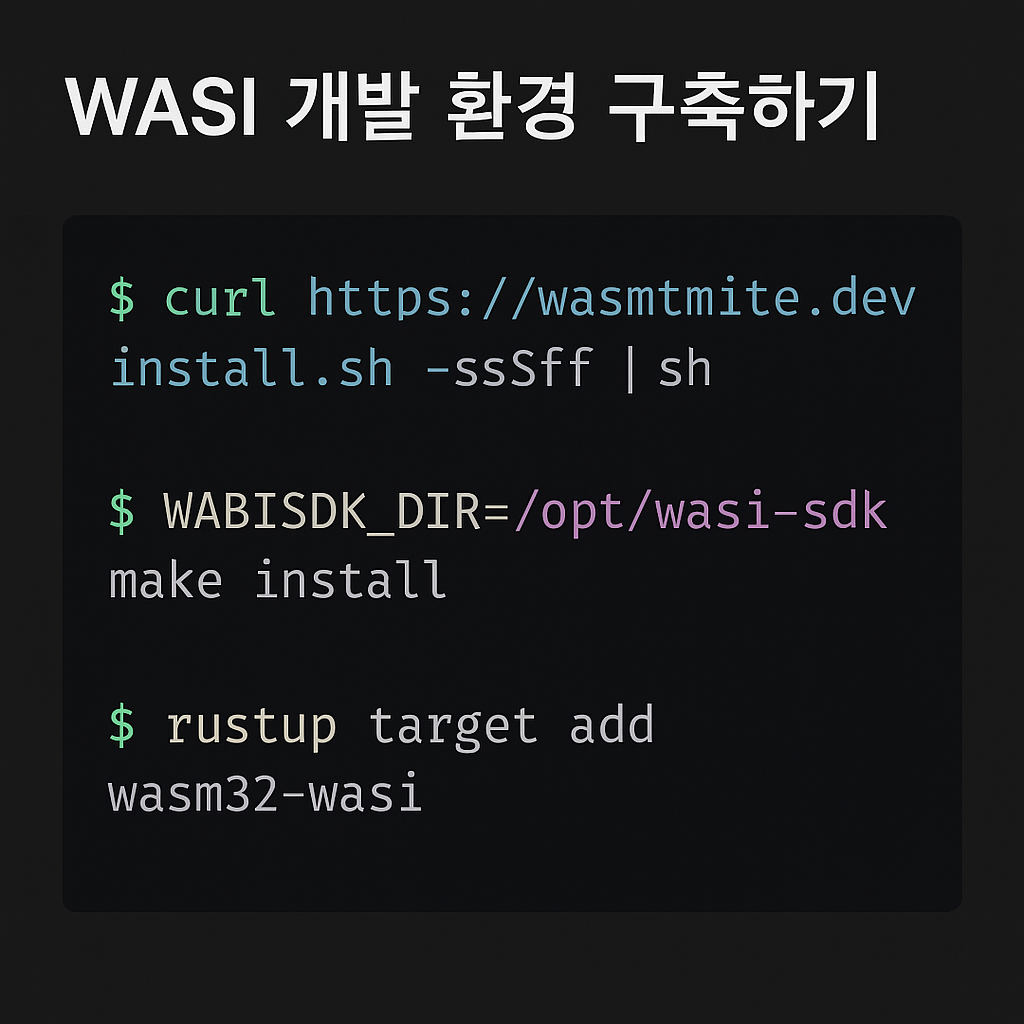

WASI 개발 환경 구축하기

WASI 개발을 시작하려면 먼저 필요한 도구들을 설치해야 합니다.

가장 인기 있는 WASI 런타임인 Wasmtime을 사용하여 개발 환경을 구축해보겠습니다.

Wasmtime 설치

# macOS/Linux

curl https://wasmtime.dev/install.sh -sSf | bash

# Windows

powershell -c "irm https://wasmtime.dev/install.ps1 | iex"WASI SDK 설치

C/C++ 코드를 WebAssembly로 컴파일하기 위해 WASI SDK가 필요합니다:

# Linux/macOS

wget https://github.com/WebAssembly/wasi-sdk/releases/download/wasi-sdk-20/wasi-sdk-20.0-linux.tar.gz

tar xvf wasi-sdk-20.0-linux.tar.gz

export WASI_SDK_PATH=/path/to/wasi-sdk-20.0Rust 개발자라면 더욱 간단하게 시작할 수 있습니다:

rustup target add wasm32-wasi

실제 WASI 애플리케이션 개발하기

이제 실제로 WASI를 사용하여 간단한 HTTP 서버를 만들어보겠습니다.

Rust를 사용한 예제부터 시작하겠습니다.

Rust로 WASI HTTP 서버 구현

// Cargo.toml

[package]

name = "wasi-http-server"

version = "0.1.0"

edition = "2021"

[dependencies]

wasi = "0.11"

serde = { version = "1.0", features = ["derive"] }

serde_json = "1.0"

// src/main.rs

use std::io::{self, Write};

use std::collections::HashMap;

fn main() {

println!("WASI HTTP 서버가 시작되었습니다!");

// 간단한 라우팅 시스템

let mut routes = HashMap::new();

routes.insert("/", handle_root);

routes.insert("/api/health", handle_health);

// 요청 처리 루프 (실제로는 더 복잡한 HTTP 파싱이 필요)

loop {

let request = read_request();

let response = process_request(&request, &routes);

write_response(response);

}

}

fn handle_root() -> String {

"Welcome to WASI HTTP Server!".to_string()

}

fn handle_health() -> String {

r#"{"status": "healthy", "timestamp": "2025-06-05T10:00:00Z"}"#.to_string()

}

fn read_request() -> String {

// 실제 HTTP 요청 파싱 구현

"GET / HTTP/1.1".to_string()

}

fn process_request(request: &str, routes: &HashMap<&str, fn() -> String>) -> String {

// 간단한 라우팅 로직

if let Some(handler) = routes.get("/") {

handler()

} else {

"404 Not Found".to_string()

}

}

fn write_response(response: String) {

println!("HTTP/1.1 200 OK\r\nContent-Length: {}\r\n\r\n{}",

response.len(), response);

}컴파일 및 실행

# Rust 코드를 WASI 바이너리로 컴파일

cargo build --target wasm32-wasi --release

# Wasmtime으로 실행

wasmtime target/wasm32-wasi/release/wasi-http-server.wasmJavaScript와 Node.js에서 WASI 활용하기

JavaScript 생태계에서도 WASI를 활용할 수 있습니다.

Node.js 20 이상에서는 기본적으로 WASI 지원이 포함되어 있어 더욱 쉽게 사용할 수 있습니다.

Node.js WASI 모듈 사용

// wasi-runner.js

import { readFile } from 'node:fs/promises';

import { WASI } from 'wasi';

import { argv, env } from 'node:process';

const wasi = new WASI({

version: 'preview1',

args: argv,

env,

preopens: {

'/tmp': '/tmp',

},

});

// WASI 바이너리 로드

const wasmBuffer = await readFile('./my-wasi-app.wasm');

const wasmModule = await WebAssembly.compile(wasmBuffer);

// WASI 인스턴스 생성 및 실행

const instance = await WebAssembly.instantiate(wasmModule, {

wasi_snapshot_preview1: wasi.wasiImport,

});

wasi.start(instance);Express.js와 WASI 통합

// express-wasi-integration.js

import express from 'express';

import { WASI } from 'wasi';

import { readFile } from 'fs/promises';

const app = express();

// WASI 모듈 로더 미들웨어

async function loadWASIModule(wasmPath) {

const wasi = new WASI({

version: 'preview1',

args: [],

env: process.env,

});

const wasmBuffer = await readFile(wasmPath);

const wasmModule = await WebAssembly.compile(wasmBuffer);

const instance = await WebAssembly.instantiate(wasmModule, {

wasi_snapshot_preview1: wasi.wasiImport,

});

return { wasi, instance };

}

// API 엔드포인트에서 WASI 모듈 활용

app.get('/api/process', async (req, res) => {

try {

const { wasi, instance } = await loadWASIModule('./data-processor.wasm');

// WASI 모듈 실행

const result = wasi.start(instance);

res.json({

success: true,

result: result,

processed_at: new Date().toISOString()

});

} catch (error) {

res.status(500).json({

error: 'WASI 모듈 실행 중 오류 발생',

details: error.message

});

}

});

app.listen(3000, () => {

console.log('Express 서버가 포트 3000에서 WASI와 함께 실행 중입니다.');

});

WASI의 보안 모델과 샌드박스

WASI의 가장 강력한 특징 중 하나는 강화된 보안 모델입니다.

기존 컨테이너 기술과 달리 WASI는 capability-based 보안 모델을 채택하고 있습니다.

Capability-based 보안

WASI 애플리케이션은 명시적으로 허용된 리소스에만 접근할 수 있습니다:

# 특정 디렉토리에만 접근 허용

wasmtime --dir=/app/data --dir=/tmp my-app.wasm

# 네트워크 접근 제한

wasmtime --allow-network=127.0.0.1:8080 my-server.wasm

# 환경 변수 제한

wasmtime --env=NODE_ENV=production my-app.wasm샌드박스 격리

WASI 애플리케이션은 다음과 같은 제약 사항을 갖습니다:

- 파일 시스템 접근은 사전에 승인된 경로로만 제한

- 네트워크 접근은 명시적으로 허용된 주소와 포트로만 제한

- 시스템 콜은 WASI 인터페이스를 통해서만 가능

- 메모리 접근은 할당한 영역으로만 제한

이러한 제약은 보안 취약점을 크게 줄여주며, 멀티테넌트 환경에서 특히 유용합니다.

마이크로서비스 아키텍처에서의 WASI 활용

WASI는 마이크로서비스 아키텍처에서 특히 빛을 발합니다.

각 서비스를 독립적인 WASI 모듈로 구현하면 배포와 관리가 훨씬 간단해집니다.

마이크로서비스 오케스트레이션

# docker-compose.yml 대신 wasi-compose.yml

version: '1.0'

services:

user-service:

wasm: ./services/user-service.wasm

env:

- DATABASE_URL=postgresql://localhost:5432/users

network:

- allow: "0.0.0.0:3001"

volumes:

- ./data/users:/app/data

order-service:

wasm: ./services/order-service.wasm

env:

- REDIS_URL=redis://localhost:6379

network:

- allow: "0.0.0.0:3002"

depends_on:

- user-service

api-gateway:

wasm: ./gateway/api-gateway.wasm

network:

- allow: "0.0.0.0:8080"

routes:

- /users/* -> user-service:3001

- /orders/* -> order-service:3002서비스 간 통신

WASI 마이크로서비스 간의 통신은 표준 HTTP나 gRPC를 사용할 수 있습니다:

// 서비스 간 HTTP 통신 예제

use std::collections::HashMap;

async fn call_user_service(user_id: u32) -> Result<UserInfo, Error> {

let url = format!("http://user-service:3001/users/{}", user_id);

// WASI의 HTTP 클라이언트 사용

let response = http_get(&url).await?;

let user_info: UserInfo = serde_json::from_str(&response)?;

Ok(user_info)

}

async fn process_order(order_data: OrderRequest) -> Result<OrderResponse, Error> {

// 사용자 정보 조회

let user = call_user_service(order_data.user_id).await?;

// 주문 처리 로직

let order = Order {

id: generate_order_id(),

user_id: user.id,

items: order_data.items,

total: calculate_total(&order_data.items),

created_at: now(),

};

// 데이터베이스에 저장

save_order(&order).await?;

Ok(OrderResponse {

order_id: order.id,

status: "created",

estimated_delivery: calculate_delivery_time(),

})

}성능 최적화와 모니터링

WASI 애플리케이션의 성능을 최적화하고 모니터링하는 방법을 알아보겠습니다.

컴파일 최적화

# Rust 최적화 컴파일

RUSTFLAGS="-C target-cpu=native -C opt-level=3" \

cargo build --target wasm32-wasi --release

# 바이너리 크기 최적화

wasm-opt -Oz input.wasm -o optimized.wasm

# 사용하지 않는 코드 제거

wasm-gc input.wasm output.wasm메모리 사용량 모니터링

// Node.js에서 WASI 메모리 사용량 모니터링

import { performance } from 'perf_hooks';

function monitorWASIMemory(instance) {

const memory = instance.exports.memory;

const memorySize = memory.buffer.byteLength;

console.log(`WASI 메모리 사용량: ${(memorySize / 1024 / 1024).toFixed(2)} MB`);

// 메모리 증가 추적

setInterval(() => {

const currentSize = memory.buffer.byteLength;

const usage = (currentSize / 1024 / 1024).toFixed(2);

if (currentSize > memorySize * 1.5) {

console.warn(`메모리 사용량 급증 감지: ${usage} MB`);

}

}, 5000);

}성능 벤치마킹

// Rust 벤치마크 코드

use std::time::Instant;

fn benchmark_wasi_function() {

let start = Instant::now();

// 벤치마크할 WASI 함수 실행

let result = process_large_data_set();

let duration = start.elapsed();

println!("함수 실행 시간: {:?}", duration);

println!("처리된 데이터: {} 건", result.len());

println!("초당 처리량: {:.2} 건/초", result.len() as f64 / duration.as_secs_f64());

}실제 프로덕션 배포 가이드

WASI 애플리케이션을 프로덕션 환경에 배포하는 방법을 단계별로 알아보겠습니다.

시스템 서비스로 등록

# systemd 서비스 파일 생성

sudo tee /etc/systemd/system/my-wasi-app.service << EOF

[Unit]

Description=My WASI Application

After=network.target

[Service]

Type=simple

User=wasi-app

Group=wasi-app

WorkingDirectory=/opt/my-wasi-app

ExecStart=/usr/local/bin/wasmtime --dir=/opt/my-wasi-app/data run app.wasm

Restart=always

RestartSec=10

[Install]

WantedBy=multi-user.target

EOF

# 서비스 활성화 및 시작

sudo systemctl enable my-wasi-app

sudo systemctl start my-wasi-app로드 밸런싱 설정

# Nginx 설정

upstream wasi_backend {

server 127.0.0.1:8080;

server 127.0.0.1:8081;

server 127.0.0.1:8082;

}

server {

listen 80;

server_name api.example.com;

location / {

proxy_pass http://wasi_backend;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

# WASI 애플리케이션의 빠른 응답을 위한 최적화

proxy_connect_timeout 1s;

proxy_send_timeout 5s;

proxy_read_timeout 5s;

}

}모니터링 및 로깅

# Prometheus metrics 수집을 위한 WASI 애플리케이션 설정

wasmtime \

--env METRICS_PORT=9090 \

--allow-network=0.0.0.0:9090 \

--dir=/var/log/wasi:/app/logs \

my-app.wasm문제 해결 및 디버깅

WASI 개발 과정에서 흔히 발생하는 문제들과 해결 방법을 알아보겠습니다.

일반적인 오류와 해결책

파일 접근 권한 오류:

# 오류: capability를 찾을 수 없음

Error: failed to find a pre-opened file descriptor

# 해결: 명시적으로 디렉토리 권한 부여

wasmtime --dir=/app/data my-app.wasm

메모리 부족 오류:

# 오류: WebAssembly 메모리 할당 실패

Error: failed to allocate memory

# 해결: 메모리 제한 증가

wasmtime --max-memory-size=1073741824 my-app.wasm # 1GB디버깅 도구 활용

# 상세한 로그 출력

WASMTIME_LOG=debug wasmtime my-app.wasm

# 성능 프로파일링

wasmtime --profile=cpu my-app.wasm

# 메모리 덤프

wasmtime --coredump-on-trap=/tmp/core.dump my-app.wasm미래 전망과 생태계

WASI 기술의 미래와 확장 가능성을 살펴보겠습니다.

WASI 2.0의 새로운 기능

WASI 2.0에서는 다음과 같은 기능들이 추가될 예정입니다:

- 비동기 I/O 지원 강화

- 네트워킹 API 표준화

- 스레딩 모델 개선

- 더 세밀한 권한 관리

클라우드 네이티브 통합

주요 클라우드 프로바이더들도 WASI 지원을 확대하고 있습니다:

- AWS Lambda의 WASI 런타임 지원

- Google Cloud Run의 WebAssembly 컨테이너

- Azure Container Instances의 WASI 백엔드

개발자 도구 생태계

WASI 개발을 지원하는 도구들이 계속해서 발전하고 있습니다:

- VS Code WASI 확장

- 통합 개발 환경 지원

- CI/CD 파이프라인 통합

- 패키지 관리자 지원

결론: WASI가 가져올 변화

WebAssembly WASI는 서버사이드 개발의 새로운 패러다임을 제시하고 있습니다.

Docker의 무거운 가상화 없이도 안전하고 효율적인 애플리케이션 배포가 가능해졌으며,

이는 특히 마이크로서비스와 서버리스 아키텍처에서 큰 장점을 보여줍니다.

WASI의 핵심 장점을 정리하면:

성능 면에서 메모리 사용량이 적고 시작 시간이 빠르며, 보안 면에서 capability-based 모델을 통한 강화된 격리를 제공합니다.

개발 생산성 면에서 언어에 구애받지 않는 크로스 플랫폼 개발이 가능하고, 운영 면에서 간소화된 배포와 관리가 가능합니다.

물론 아직 초기 단계의 기술이기 때문에 생태계가 완전히 성숙하지 않았고, 일부 고급 기능들이 부족한 상황입니다.

하지만 빠르게 발전하고 있는 커뮤니티와 주요 기업들의 지원을 바탕으로 곧 프로덕션 환경에서도 널리 사용될 것으로 예상됩니다.

WASI는 단순히 Docker의 대안이 아니라, 컨테이너 기술의 다음 진화 단계라고 할 수 있습니다.

더 가볍고, 더 안전하며, 더 효율적인 애플리케이션 실행 환경을 통해 현대적인 클라우드 네이티브 개발의 새로운 가능성을 열어가고 있습니다.

지금이야말로 WASI 기술을 학습하고 실험해볼 최적의 시기입니다.

참고 자료

'DevOps' 카테고리의 다른 글

| Terraform으로 AWS 인프라 코드화하기: 실전 모듈 작성법 (0) | 2025.06.12 |

|---|---|

| Apache Kafka vs Apache Pulsar vs RabbitMQ - 메시지 큐 선택 가이드 2025 (0) | 2025.06.09 |

| Nginx 리버스 프록시 완벽 가이드 - 로드밸런싱부터 마이크로서비스 아키텍처까지 (0) | 2025.06.01 |

| Prometheus + Grafana로 시스템 모니터링 구축: 완전한 DevOps 모니터링 솔루션 (0) | 2025.05.29 |

| Argo CD를 활용한 GitOps 구현: 쿠버네티스 자동 배포의 완벽 가이드 (0) | 2025.05.28 |