현대 컴퓨터 시스템에서 멀티코어 프로세서는 더 이상 선택이 아닌 필수가 되었습니다.

2024년 기준 대부분의 개인용 컴퓨터는 4코어 이상, 서버급 시스템은 64코어 이상을 탑재하고 있습니다.

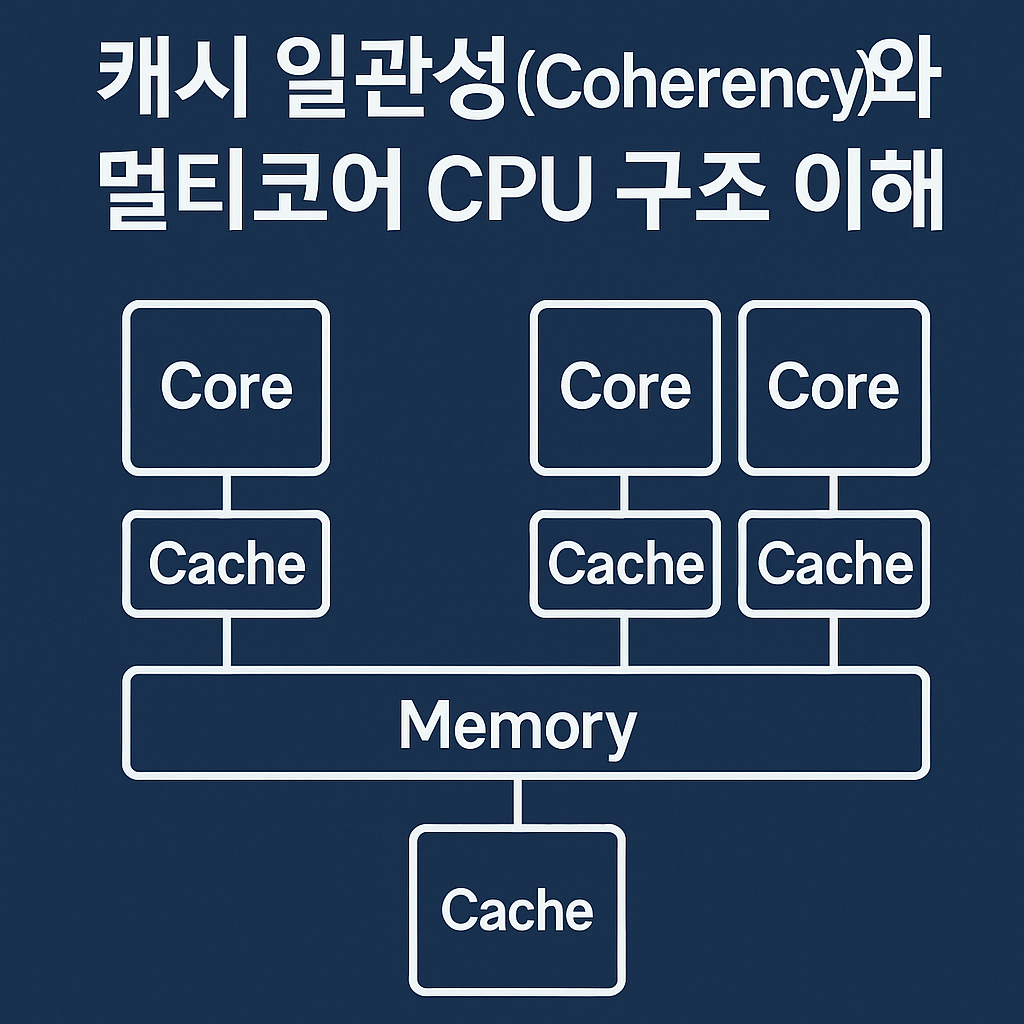

하지만 여러 개의 CPU 코어가 동시에 작동할 때 발생하는 캐시 일관성(Cache Coherency) 문제는

많은 개발자들이 간과하기 쉬운 복잡한 영역입니다.

본 가이드에서는 캐시 일관성의 핵심 개념부터 최신 멀티코어 CPU 아키텍처에서의 실제 동작 원리,

그리고 실무에서 적용할 수 있는 최적화 기법까지 상세히 다루겠습니다.

캐시 메모리의 기본 개념과 현대적 중요성

캐시 메모리는 CPU와 주 메모리(RAM) 사이에 위치하여 자주 사용되는 데이터를 임시 저장하는 고속 메모리입니다.

메모리 성능 격차(Memory Wall) 문제를 해결하기 위해 도입된 캐시는 현재 CPU 성능의 핵심 요소로 자리잡았습니다.

Intel의 최신 Raptor Lake 아키텍처나 AMD의 Zen 4 아키텍처를 살펴보면, L1, L2, L3의 정교한 계층 구조를 확인할 수 있습니다.

현대 CPU 캐시 계층 구조의 상세 분석

L1 캐시 (Level 1 Cache)

- 용량: 32KB~128KB (명령어/데이터 캐시 분리)

- 접근 시간: 1-2 클럭 사이클 (약 0.5-1ns)

- 연관성: 8-way 또는 16-way 세트 연관

- 특징: 각 코어당 전용 캐시, 가장 빠른 접근 속도

L2 캐시 (Level 2 Cache)

- 용량: 256KB~2MB

- 접근 시간: 3-12 클럭 사이클 (약 1-4ns)

- 연관성: 16-way 세트 연관

- 특징: 코어별 전용 또는 코어 쌍 공유

L3 캐시 (Level 3 Cache)

- 용량: 8MB~128MB

- 접근 시간: 15-50 클럭 사이클 (약 5-20ns)

- 연관성: 높은 연관성 (20-way 이상)

- 특징: 모든 코어가 공유하는 최종 캐시 계층

// 캐시 계층별 성능 차이 측정 예제

#include <time.h>

#include <stdio.h>

void cache_performance_test() {

const int L1_SIZE = 32 * 1024; // 32KB

const int L2_SIZE = 1024 * 1024; // 1MB

const int L3_SIZE = 8 * 1024 * 1024; // 8MB

int *data_l1 = malloc(L1_SIZE);

int *data_l2 = malloc(L2_SIZE);

int *data_l3 = malloc(L3_SIZE);

// L1 캐시 성능 측정

clock_t start = clock();

for(int i = 0; i < L1_SIZE/sizeof(int); i++) {

data_l1[i] = i * 2;

}

clock_t end = clock();

printf("L1 Cache Access Time: %f ms\n",

((double)(end - start) / CLOCKS_PER_SEC) * 1000);

// L2, L3 측정도 동일한 방식으로...

}이러한 캐시 계층 구조는 메모리 접근 지역성(Memory Access Locality) 원리를 활용하여 전체 시스템 성능을 크게 향상시킵니다.

MIT의 연구에 따르면, 캐시 적중률 1% 향상은 전체 시스템 성능을 약 2-3% 개선한다고 보고되었습니다.

멀티코어 환경에서의 캐시 일관성 문제와 도전 과제

단일 코어 시스템에서는 하나의 캐시만 존재하므로 데이터 일관성 문제가 발생하지 않습니다. 하지만 멀티코어 시스템에서는 각 코어가 독립적인 L1, L2 캐시를 가지고 있어 동일한 메모리 주소의 데이터가 여러 캐시에 동시에 존재할 수 있습니다.

이는 캐시 일관성 문제(Cache Coherency Problem)를 야기하며, 데이터 무결성과 프로그램 정확성에 심각한 영향을 미칠 수 있습니다.

실제 캐시 일관성 문제 시나리오

// 전역 공유 변수

volatile int shared_counter = 100;

int thread_results[4] = {0};

// 스레드 1 실행 함수

void* thread1_function(void* arg) {

// Step 1: shared_counter 값을 로컬 캐시로 로드 (값: 100)

int local_copy = shared_counter;

// Step 2: 값 수정

local_copy = 200;

// Step 3: 메모리에 쓰기 (다른 코어 캐시는 여전히 100)

shared_counter = local_copy;

thread_results[0] = local_copy;

return NULL;

}

// 스레드 2 실행 함수 (동시 실행)

void* thread2_function(void* arg) {

// 캐시에서 여전히 이전 값(100)을 읽을 수 있음

int value = shared_counter;

thread_results[1] = value;

printf("Thread 2 읽은 값: %d\n", value); // 예상: 200, 실제: 100 가능

return NULL;

}이 예제에서 스레드 1이 shared_counter를 200으로 변경했지만, 스레드 2는 여전히 캐시에 저장된 이전 값 100을 읽을 수 있습니다. 이는 데이터 경쟁 상태(Data Race Condition)와 메모리 일관성 위반을 야기합니다.

캐시 일관성 문제의 실무적 영향

- 금융 시스템: 잔액 계산 오류로 인한 금전적 손실

- 실시간 시스템: 센서 데이터 불일치로 인한 안전 문제

- 게임 엔진: 물리 시뮬레이션 오류로 인한 버그

- 데이터베이스: 트랜잭션 무결성 위반

IBM의 연구 보고서에 따르면, 대규모 멀티코어 시스템에서 캐시 일관성 오버헤드는 전체 성능의 15-30%까지 차지할 수 있다고 분석되었습니다.

MESI 프로토콜: 캐시 일관성 해결의 핵심 메커니즘

MESI(Modified, Exclusive, Shared, Invalid) 프로토콜은 멀티코어 시스템에서 캐시 일관성을 보장하는 가장 널리 사용되는 표준 방법입니다. 1983년 처음 제안된 이후 현재까지 Intel, AMD, ARM의 모든 주요 프로세서에서 변형된 형태로 사용되고 있습니다.

MESI 프로토콜의 네 가지 상태 심화 분석

Modified (M) - 수정됨 상태

- 의미: 캐시 라인이 수정되었으며 메인 메모리와 다른 상태

- 특징:

- 해당 데이터가 오직 이 캐시에만 존재

- 다른 캐시에는 이 데이터가 존재하지 않음 (독점 소유)

- Write-back 정책에 의해 캐시에서 제거될 때만 메인 메모리 업데이트

- 성능 영향: 메모리 대역폭 절약, 하지만 다른 코어의 읽기 요청 시 지연 발생

Exclusive (E) - 독점 상태

- 의미: 해당 캐시에만 데이터가 존재하고 메인 메모리와 일치

- 특징:

- 데이터가 깨끗한 상태 (Clean State)

- 수정 시 즉시 Modified 상태로 전환 가능

- 다른 코어의 읽기 요청 시 Shared 상태로 전환

- 최적화: 쓰기 작업 시 브로드캐스트 불필요

Shared (S) - 공유 상태

- 의미: 여러 캐시에 동일한 데이터가 존재

- 특징:

- 모든 캐시의 데이터가 메인 메모리와 일치

- 읽기 작업은 자유롭게 수행 가능

- 쓰기 작업 시 다른 모든 캐시를 Invalid 상태로 만들어야 함

- 오버헤드: 쓰기 시 브로드캐스트 및 무효화 확인 필요

Invalid (I) - 무효 상태

- 의미: 캐시 라인이 유효하지 않은 상태

- 특징:

- 데이터 접근 시 메인 메모리나 다른 캐시에서 가져와야 함

- 초기 상태 또는 무효화된 상태

- 트리거: 다른 코어의 쓰기 작업으로 인한 무효화

// MESI 프로토콜 시뮬레이션 예제

typedef enum {

INVALID = 0,

SHARED = 1,

EXCLUSIVE = 2,

MODIFIED = 3

} cache_state_t;

typedef struct {

int data;

int address;

cache_state_t state;

int core_id;

bool dirty;

} cache_line_t;

// MESI 상태 전환 함수

cache_state_t mesi_read_transition(cache_line_t* line, bool other_cache_has_data) {

switch(line->state) {

case INVALID:

return other_cache_has_data ? SHARED : EXCLUSIVE;

case SHARED:

case EXCLUSIVE:

case MODIFIED:

return line->state; // 상태 변화 없음

}

}

cache_state_t mesi_write_transition(cache_line_t* line) {

// 쓰기 작업은 항상 Modified 상태로 전환

line->dirty = true;

return MODIFIED;

}

void invalidate_other_caches(int address, int current_core) {

// 다른 모든 코어의 해당 주소 캐시 라인을 Invalid로 설정

for(int i = 0; i < MAX_CORES; i++) {

if(i != current_core) {

set_cache_state(i, address, INVALID);

}

}

}MESI 프로토콜의 성능 최적화 변형

현대 프로세서는 기본 MESI를 확장한 다양한 변형을 사용합니다:

- MOESI 프로토콜: Owned 상태 추가로 수정된 데이터 공유 최적화

- MESIF 프로토콜: Forward 상태로 캐시-to-캐시 전송 최적화

- Dragon 프로토콜: Write-through 기반의 대안적 접근

AMD의 기술 문서에 따르면, MOESI 프로토콜 사용 시 메모리 대역폭을 최대 40% 절약할 수 있다고 보고되었습니다.

캐시 일관성 프로토콜의 실제 동작 메커니즘

멀티코어 시스템에서 캐시 일관성 프로토콜이 어떻게 실제로 동작하는지 하드웨어 레벨에서 상세히 분석해보겠습니다.

버스 스누핑(Bus Snooping) 메커니즘

버스 스누핑은 각 캐시 컨트롤러가 시스템 버스의 모든 트랜잭션을 모니터링하여 캐시 일관성을 유지하는 방법입니다.

// 버스 스누핑 의사 코드

void bus_snooping_handler(bus_transaction_t* transaction) {

int address = transaction->address;

int requesting_core = transaction->core_id;

// 현재 코어의 캐시에서 해당 주소 확인

cache_line_t* line = find_cache_line(address);

if (line != NULL) {

switch(transaction->type) {

case BUS_READ:

handle_snoop_read(line, requesting_core);

break;

case BUS_WRITE:

handle_snoop_write(line, requesting_core);

break;

case BUS_INVALIDATE:

line->state = INVALID;

break;

}

}

}

void handle_snoop_read(cache_line_t* line, int requesting_core) {

switch(line->state) {

case MODIFIED:

// 수정된 데이터를 요청 코어에 제공하고 Shared로 전환

send_data_to_core(requesting_core, line->data);

writeback_to_memory(line);

line->state = SHARED;

break;

case EXCLUSIVE:

// Shared 상태로 전환

line->state = SHARED;

break;

case SHARED:

// 상태 변화 없음

break;

}

}디렉토리 기반 일관성 프로토콜

대규모 멀티코어 시스템(16코어 이상)에서는 브로드캐스트 기반 스누핑의 오버헤드가 커지므로, 디렉토리 기반 프로토콜을 사용합니다.

// 디렉토리 엔트리 구조

typedef struct {

int owner_core; // 현재 소유자 코어

bool dirty; // 수정 여부

uint64_t sharer_mask; // 공유하는 코어들의 비트마스크

int memory_address; // 메모리 주소

} directory_entry_t;

// 디렉토리 기반 읽기 처리

void directory_read_request(int address, int requesting_core) {

directory_entry_t* entry = get_directory_entry(address);

if (entry->dirty) {

// Owner에게 데이터 요청

send_data_request(entry->owner_core, address);

entry->sharer_mask |= (1 << requesting_core);

} else {

// 메모리에서 직접 제공

send_memory_data(requesting_core, address);

entry->sharer_mask |= (1 << requesting_core);

}

}캐시 미스 처리 최적화 기법

1. 비차단 캐시(Non-blocking Cache)

// 비차단 캐시 구현 예제

typedef struct {

int address;

int core_id;

callback_func_t completion_callback;

timestamp_t issue_time;

} miss_status_holding_register_t;

void handle_cache_miss_non_blocking(int address, int core_id) {

// MSHR에 요청 등록

mshr_entry_t* entry = allocate_mshr_entry();

entry->address = address;

entry->core_id = core_id;

entry->issue_time = get_current_timestamp();

// 백그라운드에서 메모리 요청 처리

issue_memory_request(address, entry);

// CPU는 다른 작업 계속 수행 가능

continue_execution(core_id);

}2. 프리패칭(Prefetching) 최적화

// 하드웨어 프리패처 구현

void stride_prefetcher(int accessed_address, int core_id) {

static int last_address[MAX_CORES] = {0};

static int stride_pattern[MAX_CORES] = {0};

int current_stride = accessed_address - last_address[core_id];

if (current_stride == stride_pattern[core_id]) {

// 일정한 패턴 감지, 다음 주소 프리패치

int prefetch_address = accessed_address + current_stride;

issue_prefetch_request(prefetch_address, core_id);

}

last_address[core_id] = accessed_address;

stride_pattern[core_id] = current_stride;

}Intel의 연구에 따르면, 효과적인 프리패칭은 캐시 미스율을 30-50% 감소시킬 수 있다고 보고되었습니다.

False Sharing: 성능 킬러의 정체와 해결책

False Sharing은 멀티코어 시스템에서 가장 흔하면서도 진단하기 어려운 성능 문제 중 하나입니다.

서로 독립적인 데이터가 동일한 캐시 라인에 위치하여 불필요한 캐시 일관성 트래픽을 발생시키는 현상입니다.

False Sharing의 심화 분석

// False Sharing 문제 예제

struct bad_design {

int counter1; // 스레드 1에서 주로 사용

int counter2; // 스레드 2에서 주로 사용

int counter3; // 스레드 3에서 주로 사용

int counter4; // 스레드 4에서 주로 사용

} shared_counters; // 모두 같은 64바이트 캐시 라인에 위치

// 성능 측정용 함수

void false_sharing_benchmark() {

pthread_t threads[4];

struct timespec start, end;

clock_gettime(CLOCK_MONOTONIC, &start);

// 4개 스레드가 각각 다른 카운터 수정

for(int i = 0; i < 4; i++) {

pthread_create(&threads[i], NULL, increment_counter, &i);

}

for(int i = 0; i < 4; i++) {

pthread_join(threads[i], NULL);

}

clock_gettime(CLOCK_MONOTONIC, &end);

long duration = (end.tv_sec - start.tv_sec) * 1000000000L +

(end.tv_nsec - start.tv_nsec);

printf("False Sharing 발생 시간: %ld ns\n", duration);

}

void* increment_counter(void* arg) {

int thread_id = *(int*)arg;

volatile int* counter;

switch(thread_id) {

case 0: counter = &shared_counters.counter1; break;

case 1: counter = &shared_counters.counter2; break;

case 2: counter = &shared_counters.counter3; break;

case 3: counter = &shared_counters.counter4; break;

}

// 각 스레드가 독립적인 카운터를 증가시키지만

// 같은 캐시 라인에 있어 서로 간섭

for(int i = 0; i < 10000000; i++) {

(*counter)++;

}

return NULL;

}False Sharing 해결책

1. 캐시 라인 정렬(Cache Line Alignment)

// 개선된 설계: 캐시 라인 정렬 사용

#define CACHE_LINE_SIZE 64

struct optimized_design {

alignas(CACHE_LINE_SIZE) int counter1;

alignas(CACHE_LINE_SIZE) int counter2;

alignas(CACHE_LINE_SIZE) int counter3;

alignas(CACHE_LINE_SIZE) int counter4;

} aligned_counters;

// 또는 패딩 사용

struct padded_design {

int counter1;

char padding1[CACHE_LINE_SIZE - sizeof(int)];

int counter2;

char padding2[CACHE_LINE_SIZE - sizeof(int)];

int counter3;

char padding3[CACHE_LINE_SIZE - sizeof(int)];

int counter4;

char padding4[CACHE_LINE_SIZE - sizeof(int)];

} __attribute__((aligned(CACHE_LINE_SIZE)));2. 스레드 로컬 누적 후 동기화

// 스레드별 로컬 누적 방식

void* optimized_increment(void* arg) {

int thread_id = *(int*)arg;

int local_counter = 0;

// 로컬에서 계산 수행 (캐시 친화적)

for(int i = 0; i < 10000000; i++) {

local_counter++;

}

// 마지막에 한 번만 전역 변수 업데이트

pthread_mutex_lock(&global_mutex);

global_counters[thread_id] = local_counter;

pthread_mutex_unlock(&global_mutex);

return NULL;

}3. 컴파일러 지시어 활용

// GCC/Clang의 캐시 라인 힌트

__attribute__((aligned(64))) int cache_aligned_var;

// C++17 이상에서의 정렬

alignas(std::hardware_destructive_interference_size) int modern_aligned_var;

// 메모리 배치 최적화 매크로

#define CACHE_ALIGNED __attribute__((aligned(CACHE_LINE_SIZE)))

#define CACHE_PADDED(type, name) \

struct { \

type name; \

char padding[CACHE_LINE_SIZE - sizeof(type)]; \

} __attribute__((aligned(CACHE_LINE_SIZE)))Google의 성능 연구에 따르면,

False Sharing 해결을 통해 멀티스레드 애플리케이션의 성능을 2-8배까지 향상시킬 수 있다고 보고되었습니다.

최신 CPU 아키텍처의 캐시 일관성 혁신

2020년대 들어 CPU 아키텍처는 캐시 일관성 오버헤드를 줄이기 위한 혁신적인 기술들을 도입하고 있습니다.

ARM의 DynamIQ 기술

ARM의 DynamIQ 아키텍처는 유연한 클러스터 구성을 통해 캐시 일관성을 최적화합니다.

// DynamIQ 클러스터 구성 예제

typedef struct {

int big_cores[4]; // 고성능 코어

int little_cores[4]; // 저전력 코어

int dsu_l3_cache; // Dynamic Shared Unit L3 캐시

int snoop_filter; // 스누프 필터

} dynamiq_cluster_t;

// 적응형 캐시 일관성 정책

void adaptive_coherency_policy(task_t* task) {

if (task->priority == HIGH_PERFORMANCE) {

// 빅 코어에 할당, 강한 일관성 보장

assign_to_big_core(task);

enable_strong_coherency(task->core_id);

} else {

// 리틀 코어에 할당, 약한 일관성으로 전력 절약

assign_to_little_core(task);

enable_weak_coherency(task->core_id);

}

}Intel의 Mesh 인터커넥트

Intel의 Mesh 아키텍처는 2D 메시 네트워크를 통해 확장성 있는 캐시 일관성을 제공합니다.

// Mesh 인터커넥트 라우팅 알고리즘

typedef struct {

int x_coord, y_coord;

int core_id;

int caching_agent_id;

int home_agent_id;

} mesh_node_t;

int calculate_mesh_distance(mesh_node_t* src, mesh_node_t* dst) {

return abs(dst->x_coord - src->x_coord) +

abs(dst->y_coord - src->y_coord);

}

void route_coherency_message(coherency_msg_t* msg) {

mesh_node_t* current = &mesh_nodes[msg->current_node];

mesh_node_t* target = &mesh_nodes[msg->target_node];

// 최단 경로 라우팅 (XY 라우팅)

if (current->x_coord != target->x_coord) {

// X 방향으로 이동

msg->next_hop = get_x_neighbor(current, target);

} else {

// Y 방향으로 이동

msg->next_hop = get_y_neighbor(current, target);

}

forward_message(msg);

}AMD의 Infinity Fabric

AMD의 Infinity Fabric은 확장 가능한 일관성 도메인을 제공합니다.

// Infinity Fabric 일관성 도메인 관리

typedef struct {

int domain_id;

int numa_node;

cache_coherency_state_t coherency_state;

bandwidth_monitor_t bandwidth_monitor;

} if_coherency_domain_t;

void manage_if_coherency(if_coherency_domain_t* domain, memory_request_t* req) {

if (is_local_domain(domain, req->address)) {

// 로컬 도메인 내 빠른 일관성 처리

handle_local_coherency(domain, req);

} else {

// 크로스 도메인 일관성 처리 (더 높은 지연시간)

handle_cross_domain_coherency(domain, req);

// 대역폭 모니터링 및 적응형 정책 적용

if (domain->bandwidth_monitor.utilization > 0.8) {

apply_bandwidth_throttling(domain);

}

}

}실무 중심 캐시 최적화 프로그래밍 기법

효율적인 멀티코어 프로그래밍을 위해서는 캐시 일관성을 고려한 실무적 코딩 기법이 필수입니다.

메모리 접근 패턴 최적화 심화

1. 공간 지역성(Spatial Locality) 극대화

// 비효율적인 메모리 접근 패턴

void inefficient_matrix_multiplication(float** A, float** B, float** C, int N) {

for(int i = 0; i < N; i++) {

for(int j = 0; j < N; j++) {

for(int k = 0; k < N; k++) {

// B[k][j] 접근이 캐시 미스를 자주 발생시킴

C[i][j] += A[i][k] * B[k][j];

}

}

}

}

// 캐시 최적화된 블록 행렬 곱셈

void cache_optimized_matrix_multiplication(float** A, float** B, float** C, int N) {

const int BLOCK_SIZE = 64; // L1 캐시 크기에 맞춤

for(int ii = 0; ii < N; ii += BLOCK_SIZE) {

for(int jj = 0; jj < N; jj += BLOCK_SIZE) {

for(int kk = 0; kk < N; kk += BLOCK_SIZE) {

// 블록 단위로 처리하여 캐시 지역성 향상

for(int i = ii; i < min(ii + BLOCK_SIZE, N); i++) {

for(int j = jj; j < min(jj + BLOCK_SIZE, N); j++) {

for(int k = kk; k < min(kk + BLOCK_SIZE, N); k++) {

C[i][j] += A[i][k] * B[k][j];

}

}

}

}

}

}

}

// 성능 측정 함수

void benchmark_matrix_multiplication() {

const int N = 1024;

float** A = allocate_matrix(N, N);

float** B = allocate_matrix(N, N);

float** C1 = allocate_matrix(N, N);

float** C2 = allocate_matrix(N, N);

// 초기화

initialize_random_matrix(A, N, N);

initialize_random_matrix(B, N, N);

// 비최적화 버전 측정

auto start = std::chrono::high_resolution_clock::now();

inefficient_matrix_multiplication(A, B, C1, N);

auto end = std::chrono::high_resolution_clock::now();

auto duration1 = std::chrono::duration_cast<std::chrono::milliseconds>(end - start);

// 최적화 버전 측정

start = std::chrono::high_resolution_clock::now();

cache_optimized_matrix_multiplication(A, B, C2, N);

end = std::chrono::high_resolution_clock::now();

auto duration2 = std::chrono::duration_cast<std::chrono::milliseconds>(end - start);

printf("비최적화 버전: %ld ms\n", duration1.count());

printf("최적화 버전: %ld ms\n", duration2.count());

printf("성능 향상: %.2fx\n", (double)duration1.count() / duration2.count());

}2. 시간 지역성(Temporal Locality) 활용

// 데이터 구조 재배치를 통한 캐시 효율성 향상

typedef struct {

// Hot data (자주 접근되는 데이터)

int id;

int status;

float priority;

// Cold data (가끔 접근되는 데이터)

char description[256];

timestamp_t creation_time;

metadata_t metadata;

} optimized_object_t;

// vs 비최적화된 구조

typedef struct {

int id;

char description[256]; // 큰 데이터가 중간에 위치

int status; // Hot data가 분산됨

timestamp_t creation_time;

float priority;

metadata_t metadata;

} unoptimized_object_t;

// 캐시 친화적 데이터 처리

void process_objects_cache_friendly(optimized_object_t* objects, int count) {

// Phase 1: Hot data만 먼저 처리

for(int i = 0; i < count; i++) {

if(objects[i].status == ACTIVE && objects[i].priority > 0.5f) {

process_hot_data(&objects[i]);

}

}

// Phase 2: 필요한 경우만 Cold data 접근

for(int i = 0; i < count; i++) {

if(objects[i].status == NEEDS_DETAIL_PROCESSING) {

process_cold_data(&objects[i]);

}

}

}고급 동기화 최적화 기법

1. Lock-free 프로그래밍과 캐시 일관성

#include <stdatomic.h>

// Lock-free 스택 구현 (캐시 최적화)

typedef struct node {

atomic_intptr_t data;

struct node* next;

} node_t;

typedef struct {

alignas(64) atomic_uintptr_t head; // 캐시 라인 정렬

alignas(64) atomic_long push_count; // 통계용, False Sharing 방지

alignas(64) atomic_long pop_count; // 통계용, False Sharing 방지

} lockfree_stack_t;

void lockfree_push(lockfree_stack_t* stack, intptr_t data) {

node_t* new_node = malloc(sizeof(node_t));

atomic_store(&new_node->data, data);

uintptr_t old_head;

do {

old_head = atomic_load(&stack->head);

new_node->next = (node_t*)old_head;

// Compare-and-swap으로 원자적 업데이트

// 캐시 일관성은 하드웨어가 자동 처리

} while(!atomic_compare_exchange_weak(&stack->head, &old_head, (uintptr_t)new_node));

atomic_fetch_add(&stack->push_count, 1);

}

intptr_t lockfree_pop(lockfree_stack_t* stack) {

uintptr_t old_head;

node_t* head;

do {

old_head = atomic_load(&stack->head);

head = (node_t*)old_head;

if(head == NULL) {

return 0; // 스택이 비어있음

}

// ABA 문제 해결을 위한 추가 검증 필요

} while(!atomic_compare_exchange_weak(&stack->head, &old_head, (uintptr_t)head->next));

intptr_t data = atomic_load(&head->data);

free(head);

atomic_fetch_add(&stack->pop_count, 1);

return data;

}2. 읽기-쓰기 락의 캐시 최적화

// 캐시 라인 정렬된 읽기-쓰기 락

typedef struct {

alignas(64) atomic_int reader_count;

alignas(64) atomic_bool writer_flag;

alignas(64) atomic_int writer_waiting;

} cache_optimized_rwlock_t;

void rwlock_read_lock(cache_optimized_rwlock_t* lock) {

while(true) {

// 쓰기 대기자가 있으면 양보

while(atomic_load(&lock->writer_waiting) > 0 ||

atomic_load(&lock->writer_flag)) {

cpu_relax(); // CPU 힌트: 스핀 대기 중

}

atomic_fetch_add(&lock->reader_count, 1);

// 더블 체크: 쓰기자가 중간에 진입하지 않았는지 확인

if(!atomic_load(&lock->writer_flag)) {

break; // 성공적으로 읽기 락 획득

}

atomic_fetch_sub(&lock->reader_count, 1);

}

}

void rwlock_write_lock(cache_optimized_rwlock_t* lock) {

atomic_fetch_add(&lock->writer_waiting, 1);

// 다른 쓰기자 대기

while(!atomic_compare_exchange_weak(&lock->writer_flag,

&(bool){false}, true)) {

cpu_relax();

}

// 모든 읽기자가 끝날 때까지 대기

while(atomic_load(&lock->reader_count) > 0) {

cpu_relax();

}

atomic_fetch_sub(&lock->writer_waiting, 1);

}메모리 배치 최적화 전략

1. NUMA-aware 프로그래밍

#include <numa.h>

#include <numaif.h>

// NUMA 토폴로지 인식 메모리 할당

void* numa_aware_allocation(size_t size, int preferred_node) {

void* ptr = numa_alloc_onnode(size, preferred_node);

if(ptr == NULL) {

// 폴백: 로컬 노드에 할당

ptr = numa_alloc_local(size);

}

// 메모리 정책 설정: 해당 노드에서만 할당

numa_set_bind_policy(1);

return ptr;

}

// 스레드-노드 친화성 설정

void setup_thread_numa_affinity(pthread_t thread, int numa_node) {

cpu_set_t cpuset;

CPU_ZERO(&cpuset);

// 해당 NUMA 노드의 CPU들을 가져와서 설정

struct bitmask* node_cpus = numa_allocate_cpumask();

numa_node_to_cpus(numa_node, node_cpus);

for(int cpu = 0; cpu < numa_num_possible_cpus(); cpu++) {

if(numa_bitmask_isbitset(node_cpus, cpu)) {

CPU_SET(cpu, &cpuset);

}

}

pthread_setaffinity_np(thread, sizeof(cpuset), &cpuset);

numa_free_cpumask(node_cpus);

}

// NUMA-aware 병렬 처리

void numa_parallel_processing(data_chunk_t* data, int total_chunks) {

int num_nodes = numa_max_node() + 1;

int chunks_per_node = total_chunks / num_nodes;

for(int node = 0; node < num_nodes; node++) {

thread_args_t* args = malloc(sizeof(thread_args_t));

args->data = &data[node * chunks_per_node];

args->chunk_count = chunks_per_node;

args->numa_node = node;

pthread_t thread;

pthread_create(&thread, NULL, numa_worker_thread, args);

setup_thread_numa_affinity(thread, node);

}

}Facebook의 연구에 따르면, NUMA-aware 최적화를 통해 대규모 서버 애플리케이션의 성능을

20-40% 향상시킬 수 있다고 보고되었습니다.

캐시 일관성 성능 분석과 디버깅 도구

멀티코어 환경에서 캐시 관련 성능 문제를 정확히 진단하고 해결하기 위한 체계적인 접근법을 제시합니다.

하드웨어 성능 카운터 활용

1. Linux perf를 이용한 상세 분석

# 기본 캐시 성능 측정

perf stat -e cache-misses,cache-references,L1-dcache-load-misses,L1-dcache-loads,L1-icache-load-misses ./your_program

# 상세한 캐시 이벤트 추적

perf record -e cache-misses:u,cache-references:u,cycles:u,instructions:u ./your_program

perf report --sort=dso,symbol

# False Sharing 탐지를 위한 특별 이벤트

perf c2c record ./your_program

perf c2c report

2. Intel VTune을 활용한 정밀 분석

#include <ittnotify.h>

// Intel VTune 마커를 이용한 코드 영역 분석

void analyze_cache_performance() {

__itt_domain* domain = __itt_domain_create("CacheAnalysis");

__itt_string_handle* task = __itt_string_handle_create("MatrixMultiplication");

__itt_task_begin(domain, __itt_null, __itt_null, task);

// 분석할 코드 영역

cache_optimized_matrix_multiplication(A, B, C, N);

__itt_task_end(domain);

}

// 메모리 접근 패턴 분석을 위한 커스텀 프로파일러

typedef struct {

uint64_t address;

uint64_t timestamp;

int access_type; // 0: read, 1: write

int thread_id;

} memory_access_log_t;

void log_memory_access(void* addr, int type) {

static __thread memory_access_log_t local_log[1024];

static __thread int log_index = 0;

if(log_index < 1024) {

local_log[log_index].address = (uint64_t)addr;

local_log[log_index].timestamp = rdtsc(); // CPU 타임스탬프

local_log[log_index].access_type = type;

local_log[log_index].thread_id = gettid();

log_index++;

}

}3. 캐시 시뮬레이션을 통한 정확한 분석

// 간단한 캐시 시뮬레이터 구현

typedef struct {

int valid;

uint64_t tag;

uint64_t address;

int lru_counter;

} cache_line_sim_t;

typedef struct {

cache_line_sim_t* lines;

int size;

int associativity;

int line_size;

int sets;

// 통계

uint64_t hits;

uint64_t misses;

uint64_t invalidations;

} cache_simulator_t;

cache_simulator_t* create_cache_simulator(int size_kb, int assoc, int line_size) {

cache_simulator_t* sim = malloc(sizeof(cache_simulator_t));

sim->size = size_kb * 1024;

sim->associativity = assoc;

sim->line_size = line_size;

sim->sets = sim->size / (sim->associativity * sim->line_size);

sim->lines = calloc(sim->sets * sim->associativity, sizeof(cache_line_sim_t));

sim->hits = 0;

sim->misses = 0;

sim->invalidations = 0;

return sim;

}

int simulate_cache_access(cache_simulator_t* sim, uint64_t address) {

uint64_t line_addr = address / sim->line_size;

int set_index = line_addr % sim->sets;

uint64_t tag = line_addr / sim->sets;

// 해당 세트에서 태그 검색

for(int way = 0; way < sim->associativity; way++) {

int index = set_index * sim->associativity + way;

if(sim->lines[index].valid && sim->lines[index].tag == tag) {

// 캐시 히트

sim->hits++;

sim->lines[index].lru_counter = 0; // LRU 업데이트

return 1;

}

}

// 캐시 미스 - LRU 교체

sim->misses++;

int victim_way = find_lru_victim(sim, set_index);

int victim_index = set_index * sim->associativity + victim_way;

sim->lines[victim_index].valid = 1;

sim->lines[victim_index].tag = tag;

sim->lines[victim_index].address = address;

sim->lines[victim_index].lru_counter = 0;

return 0;

}False Sharing 자동 탐지 도구

// False Sharing 탐지를 위한 런타임 도구

#define CACHE_LINE_SIZE 64

typedef struct {

uint64_t address;

int thread_id;

uint64_t timestamp;

int access_type;

} access_record_t;

static access_record_t access_history[MAX_RECORDS];

static atomic_int record_index = 0;

void detect_false_sharing() {

int current_idx = atomic_load(&record_index);

for(int i = 0; i < current_idx - 1; i++) {

for(int j = i + 1; j < current_idx; j++) {

access_record_t* a1 = &access_history[i];

access_record_t* a2 = &access_history[j];

// 같은 캐시 라인, 다른 스레드, 시간 근접

if(same_cache_line(a1->address, a2->address) &&

a1->thread_id != a2->thread_id &&

abs(a1->timestamp - a2->timestamp) < TEMPORAL_THRESHOLD &&

(a1->access_type == WRITE || a2->access_type == WRITE)) {

printf("False Sharing 탐지!\n");

printf("주소1: 0x%lx (스레드 %d), 주소2: 0x%lx (스레드 %d)\n",

a1->address, a1->thread_id, a2->address, a2->thread_id);

}

}

}

}

bool same_cache_line(uint64_t addr1, uint64_t addr2) {

return (addr1 / CACHE_LINE_SIZE) == (addr2 / CACHE_LINE_SIZE);

}

// 메모리 접근 인터셉터 (컴파일러 플러그인 또는 바이너리 계측)

void __attribute__((no_instrument_function))

intercept_memory_access(void* addr, size_t size, int is_write) {

int idx = atomic_fetch_add(&record_index, 1);

if(idx < MAX_RECORDS) {

access_history[idx].address = (uint64_t)addr;

access_history[idx].thread_id = gettid();

access_history[idx].timestamp = rdtsc();

access_history[idx].access_type = is_write ? WRITE : READ;

}

}미래 지향적 캐시 일관성 기술 동향

캐시 일관성 기술은 인공지능, 양자 컴퓨팅, 그리고 새로운 메모리 기술의 발전과 함께 계속 진화하고 있습니다.

AI 기반 적응형 캐시 관리

1. 머신러닝 예측 모델을 활용한 캐시 정책

import tensorflow as tf

import numpy as np

class CachePredictionModel:

def __init__(self):

self.model = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu', input_shape=(10,)),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(32, activation='relu'),

tf.keras.layers.Dense(1, activation='sigmoid') # 캐시 히트 확률

])

self.model.compile(optimizer='adam',

loss='binary_crossentropy',

metrics=['accuracy'])

def train(self, access_patterns, hit_labels):

"""

access_patterns: 메모리 접근 패턴 특징

hit_labels: 실제 캐시 히트 여부

"""

self.model.fit(access_patterns, hit_labels,

epochs=100, batch_size=32, validation_split=0.2)

def predict_cache_hit(self, current_pattern):

"""현재 접근 패턴에 대한 캐시 히트 확률 예측"""

return self.model.predict(current_pattern.reshape(1, -1))[0][0]

# 특징 추출 함수

def extract_access_features(access_history, current_addr):

features = []

# 1. 시간적 지역성: 최근 접근 간격

recent_accesses = [acc for acc in access_history[-10:]

if abs(acc.address - current_addr) < 1024]

features.append(len(recent_accesses))

# 2. 공간적 지역성: 인접 주소 접근 패턴

spatial_score = sum(1 for acc in access_history[-20:]

if abs(acc.address - current_addr) <= 64)

features.append(spatial_score)

# 3. 스트라이드 패턴

strides = [access_history[i+1].address - access_history[i].address

for i in range(len(access_history)-1)]

features.append(np.mean(strides) if strides else 0)

features.append(np.std(strides) if strides else 0)

# 4. 스레드 간 간섭 패턴

thread_conflicts = sum(1 for acc in access_history[-10:]

if acc.thread_id != current_thread_id())

features.append(thread_conflicts)

# 나머지 특징들...

features.extend([0] * (10 - len(features))) # 패딩

return np.array(features)2. 강화학습 기반 캐시 교체 정책

// Q-Learning 기반 캐시 교체 알고리즘

typedef struct {

float q_table[MAX_CACHE_STATES][MAX_ACTIONS];

float learning_rate;

float discount_factor;

float exploration_rate;

int current_state;

} rl_cache_controller_t;

typedef enum {

ACTION_LRU = 0,

ACTION_LFU = 1,

ACTION_RANDOM = 2,

ACTION_FIFO = 3,

MAX_ACTIONS = 4

} cache_action_t;

int get_cache_state(cache_simulator_t* cache) {

// 캐시 상태를 정수로 인코딩

int state = 0;

state |= (cache->hits & 0xFF) << 24;

state |= (cache->misses & 0xFF) << 16;

state |= (cache->recent_conflicts & 0xFF) << 8;

state |= (cache->access_pattern_type & 0xFF);

return state % MAX_CACHE_STATES;

}

cache_action_t rl_select_action(rl_cache_controller_t* controller, int state) {

if(uniform_random() < controller->exploration_rate) {

// 탐험: 무작위 행동

return rand() % MAX_ACTIONS;

} else {

// 활용: 최적 행동 선택

cache_action_t best_action = 0;

float best_q_value = controller->q_table[state][0];

for(int action = 1; action < MAX_ACTIONS; action++) {

if(controller->q_table[state][action] > best_q_value) {

best_q_value = controller->q_table[state][action];

best_action = action;

}

}

return best_action;

}

}

void rl_update_q_table(rl_cache_controller_t* controller,

int old_state, cache_action_t action,

float reward, int new_state) {

float old_q = controller->q_table[old_state][action];

float max_future_q = 0;

for(int a = 0; a < MAX_ACTIONS; a++) {

if(controller->q_table[new_state][a] > max_future_q) {

max_future_q = controller->q_table[new_state][a];

}

}

float new_q = old_q + controller->learning_rate *

(reward + controller->discount_factor * max_future_q - old_q);

controller->q_table[old_state][action] = new_q;

}비휘발성 메모리와 새로운 캐시 구조

1. 3D XPoint/Optane을 활용한 하이브리드 캐시

// 비휘발성 메모리 기반 지속성 캐시

typedef struct {

cache_line_t* volatile_cache; // SRAM/DRAM 기반 빠른 캐시

cache_line_t* persistent_cache; // 3D XPoint 기반 지속성 캐시

int volatile_size;

int persistent_size;

// 마이그레이션 정책

migration_policy_t migration_policy;

} hybrid_cache_t;

void hybrid_cache_access(hybrid_cache_t* cache, uint64_t address) {

// 1단계: 휘발성 캐시 확인

cache_line_t* volatile_line = lookup_volatile_cache(cache, address);

if(volatile_line) {

// 빠른 히트

return;

}

// 2단계: 지속성 캐시 확인

cache_line_t* persistent_line = lookup_persistent_cache(cache, address);

if(persistent_line) {

// 중간 속도 히트, 필요시 휘발성 캐시로 승격

if(should_promote_to_volatile(persistent_line)) {

migrate_to_volatile_cache(cache, persistent_line);

}

return;

}

// 3단계: 메모리에서 로드

cache_line_t* new_line = load_from_memory(address);

// 적응형 배치: 접근 패턴에 따라 캐시 레벨 결정

if(predict_hot_data(address)) {

insert_to_volatile_cache(cache, new_line);

} else {

insert_to_persistent_cache(cache, new_line);

}

}

// 지속성 캐시의 전력 효율적 일관성 프로토콜

void persistent_cache_coherency_update(hybrid_cache_t* cache, uint64_t address) {

// 배터리 백업 또는 커패시터를 이용한 지속성 보장

if(power_failure_detected()) {

flush_volatile_to_persistent(cache);

update_persistent_metadata(cache, address);

}

// 일반적인 경우: 지연된 지속성 업데이트

schedule_lazy_persistent_update(cache, address);

}2. 양자 간섭 기반 캐시 일관성

// 양자 컴퓨팅 원리를 응용한 확률적 캐시 일관성

typedef struct {

float coherency_probability; // 일관성 확률

float entanglement_strength; // 캐시 간 얽힘 강도

complex_t quantum_state; // 양자 상태 표현

} quantum_cache_state_t;

// 양자 간섭을 모사한 확률적 일관성 체크

bool quantum_coherency_check(quantum_cache_state_t* cache1,

quantum_cache_state_t* cache2) {

// 양자 얽힘 상태에서의 확률적 일관성 계산

float interference_factor = cache1->entanglement_strength *

cache2->entanglement_strength;

float coherency_prob = cache1->coherency_probability *

cache2->coherency_probability *

interference_factor;

return (uniform_random() < coherency_prob);

}

// 양자 중첩 상태를 활용한 다중 캐시 상태 관리

void quantum_superposition_cache_update(quantum_cache_state_t* caches,

int num_caches, uint64_t address) {

// 모든 캐시가 동시에 여러 상태의 중첩 상태 유지

for(int i = 0; i < num_caches; i++) {

caches[i].quantum_state = create_superposition_state(

caches[i].quantum_state, address);

}

// 관측(측정) 시점에서 상태 결정

when_cache_accessed(address) {

collapse_quantum_state(caches, num_caches, address);

}

}차세대 인터커넥트 기술

1. 포토닉(Photonic) 인터커넥트 기반 캐시 일관성

// 광학 기반 초고속 캐시 간 통신

typedef struct {

wavelength_t wavelength; // 전용 파장

optical_power_t power_level; // 광 신호 강도

modulation_t modulation_type; // 변조 방식

latency_ns_t propagation_delay; // 전파 지연 (나노초 단위)

} optical_cache_link_t;

void photonic_coherency_broadcast(cache_coherency_msg_t* msg,

optical_cache_link_t* links,

int num_links) {

// 모든 캐시에 동시 브로드캐스트 (광속 전파)

for(int i = 0; i < num_links; i++) {

optical_encode_message(msg, links[i].wavelength);

optical_transmit(msg, &links[i]);

}

// 광학 신호는 전기 신호보다 100배 빠른 전파 속도

// 대규모 시스템에서 캐시 일관성 레이턴시 대폭 감소

}

// WDM(파장 분할 다중화)을 이용한 병렬 일관성 처리

void wdm_parallel_coherency(cache_system_t* cache_system) {

wavelength_t wavelengths[] = {1310, 1550, 1490, 1470}; // nm 단위

for(int i = 0; i < 4; i++) {

// 각 파장별로 독립적인 일관성 채널 운용

coherency_channel_t* channel = &cache_system->channels[i];

channel->wavelength = wavelengths[i];

channel->dedicated_caches = get_cache_subset(i);

// 병렬 처리로 전체 일관성 처리량 증대

spawn_coherency_handler_thread(channel);

}

}2. 신경형 컴퓨팅(Neuromorphic) 캐시 아키텍처

// 뇌의 신경망을 모사한 적응형 캐시 시스템

typedef struct {

float synaptic_weight; // 시냅스 가중치 (접근 빈도)

float activation_threshold; // 활성화 임계값

float decay_rate; // 시간에 따른 감쇠율

uint64_t last_access_time; // 마지막 접근 시간

} neuromorphic_cache_line_t;

typedef struct {

neuromorphic_cache_line_t* neurons; // 캐시 라인을 뉴런으로 모델링

float learning_rate; // 학습률

int network_topology; // 네트워크 토폴로지

} neuromorphic_cache_t;

void neuromorphic_cache_access(neuromorphic_cache_t* cache,

uint64_t address, int access_type) {

int neuron_id = address_to_neuron_mapping(address);

neuromorphic_cache_line_t* neuron = &cache->neurons[neuron_id];

// 시냅스 강화 (Hebbian Learning)

neuron->synaptic_weight += cache->learning_rate *

calculate_activation_strength(access_type);

// 주변 뉴런들과의 연결 강화 (공간적 지역성)

strengthen_neighbor_connections(cache, neuron_id, address);

// 시간 감쇠 적용

apply_temporal_decay(neuron);

// 네트워크 전체 최적화

if(should_trigger_global_optimization()) {

neuromorphic_network_optimization(cache);

}

}

// 스파이킹 신경망 기반 예측적 프리패칭

void spiking_neural_prefetcher(neuromorphic_cache_t* cache,

uint64_t current_address) {

float spike_potential = 0.0f;

// 현재 접근 패턴을 기반으로 스파이크 전위 계산

for(int i = 0; i < cache->network_size; i++) {

neuromorphic_cache_line_t* neuron = &cache->neurons[i];

if(is_spatially_related(neuron->address, current_address)) {

spike_potential += neuron->synaptic_weight *

calculate_spatial_correlation(neuron->address, current_address);

}

}

// 임계값 초과 시 예측적 프리패치 수행

if(spike_potential > PREFETCH_THRESHOLD) {

uint64_t predicted_address = neural_predict_next_access(cache, current_address);

issue_prefetch_request(predicted_address);

// 예측 정확도를 피드백으로 학습률 조정

cache->learning_rate = adaptive_learning_rate_adjustment(

cache->learning_rate, get_prediction_accuracy());

}

}산업별 캐시 일관성 최적화 사례 연구

실제 산업 현장에서 캐시 일관성 최적화가 어떻게 적용되고 있는지 구체적인 사례를 통해 살펴보겠습니다.

금융 거래 시스템의 초저지연 캐시 최적화

1. 고빈도 거래(HFT) 시스템의 캐시 전략

// 마이크로초 단위 최적화가 필요한 거래 시스템

typedef struct {

alignas(64) volatile uint64_t bid_price;

alignas(64) volatile uint64_t ask_price;

alignas(64) volatile uint32_t volume;

alignas(64) volatile uint64_t timestamp;

// 각 필드를 별도 캐시 라인에 배치하여 False Sharing 완전 제거

} __attribute__((packed)) market_data_t;

// 캐시 미스를 최소화하는 거래 엔진

typedef struct {

market_data_t* hot_instruments[MAX_HOT_INSTRUMENTS]; // L1에 상주

market_data_t* warm_instruments[MAX_WARM_INSTRUMENTS]; // L2에 상주

// 예측적 로딩을 위한 거래 패턴 분석

trading_pattern_analyzer_t pattern_analyzer;

} trading_engine_cache_t;

void ultra_low_latency_trade_processing(trading_engine_cache_t* engine,

trade_order_t* order) {

// 단계 1: 캐시 워밍업 (예측적 로딩)

if(is_market_opening_time()) {

prefetch_likely_instruments(engine, order->symbol);

}

// 단계 2: 캐시 라인 단위 원자적 업데이트

market_data_t* data = get_instrument_data_l1_resident(engine, order->symbol);

// 단일 캐시 라인 내에서 모든 업데이트 완료 (원자성 보장)

__transaction_atomic { // Intel TSX 하드웨어 트랜잭션

if(order->side == BUY && order->price >= data->ask_price) {

execute_immediate_trade(order, data);

update_market_data_atomic(data, order);

}

}

// 단계 3: 다른 코어로의 즉시 전파 (브로드캐스트 최적화)

broadcast_trade_execution_cache_optimized(order, data);

}

// NUMA 토폴로지를 고려한 거래 데이터 배치

void optimize_trading_data_placement() {

// CPU 소켓별로 거래 데이터 분할 배치

for(int socket = 0; socket < num_cpu_sockets; socket++) {

instrument_group_t* group = &instrument_groups[socket];

// 해당 소켓의 로컬 메모리에 할당

group->data = numa_alloc_onnode(sizeof(market_data_t) * group->count, socket);

// 거래량 기반 동적 재배치

if(should_rebalance_based_on_volume(group)) {

migrate_hot_instruments_to_faster_socket(group);

}

}

}CME Group의 기술 보고서에 따르면, 캐시 최적화를 통해 거래 지연시간을 50% 이상 단축할 수 있다고 발표했습니다.

게임 엔진의 실시간 렌더링 캐시 최적화

2. AAA 게임의 멀티스레드 렌더링 파이프라인

// 게임 오브젝트 캐시 최적화 구조

typedef struct {

// Transform 데이터 (매 프레임 접근)

alignas(64) float position[3];

alignas(64) float rotation[4]; // 쿼터니언

alignas(64) float scale[3];

// 렌더링 데이터 (컬링 후 접근)

alignas(64) mesh_id_t mesh_id;

alignas(64) material_id_t material_id;

alignas(64) uint32_t render_flags;

} game_object_transform_t;

typedef struct {

// 자주 변경되지 않는 데이터는 별도 구조로 분리

mesh_data_t mesh_data;

texture_data_t texture_data;

animation_data_t animation_data;

} game_object_static_data_t;

// 캐시 효율적인 렌더링 파이프라인

void cache_optimized_rendering_pipeline() {

const int BATCH_SIZE = 64; // L1 캐시에 맞는 배치 크기

// Phase 1: Transform 업데이트 (캐시 집약적)

for(int batch_start = 0; batch_start < num_objects; batch_start += BATCH_SIZE) {

int batch_end = min(batch_start + BATCH_SIZE, num_objects);

// 배치 단위로 변환 행렬 계산 (벡터화 최적화)

update_transforms_vectorized(&game_objects[batch_start],

batch_end - batch_start);

}

// Phase 2: 컬링 및 가시성 판정

parallel_for(int thread_id = 0; thread_id < num_render_threads; thread_id++) {

int objects_per_thread = num_objects / num_render_threads;

int start_idx = thread_id * objects_per_thread;

int end_idx = (thread_id + 1) * objects_per_thread;

// 스레드별 로컬 가시 객체 리스트 (False Sharing 방지)

visible_object_list_t local_visible_list;

frustum_culling_cache_optimized(&game_objects[start_idx],

end_idx - start_idx,

&local_visible_list);

// 스레드 로컬 결과를 최종 리스트에 병합

merge_visible_lists(&global_visible_list, &local_visible_list, thread_id);

}

// Phase 3: 드로우 콜 생성 (상태 변경 최소화)

generate_draw_calls_state_sorted(&global_visible_list);

}

// GPU 리소스와 연동된 캐시 관리

void gpu_cache_coherent_resource_management() {

// GPU 메모리와 CPU 캐시 간 일관성 관리

for(int i = 0; i < num_dynamic_meshes; i++) {

dynamic_mesh_t* mesh = &dynamic_meshes[i];

if(mesh->cpu_modified) {

// CPU에서 수정된 데이터를 GPU로 전송

// 이때 CPU 캐시도 무효화하여 일관성 보장

flush_cpu_cache_range(mesh->vertex_data, mesh->vertex_data_size);

upload_to_gpu_buffer(mesh->gpu_buffer, mesh->vertex_data, mesh->vertex_data_size);

mesh->cpu_modified = false;

}

if(mesh->gpu_modified) {

// GPU에서 수정된 데이터를 CPU로 동기화

download_from_gpu_buffer(mesh->vertex_data, mesh->gpu_buffer, mesh->vertex_data_size);

invalidate_cpu_cache_range(mesh->vertex_data, mesh->vertex_data_size);

mesh->gpu_modified = false;

}

}

}

3. 실시간 물리 시뮬레이션의 캐시 최적화

// 물리 엔진 캐시 최적화 구조

typedef struct {

// Hot data: 매 시뮬레이션 스텝마다 접근

alignas(64) float position[3];

alignas(64) float velocity[3];

alignas(64) float acceleration[3];

alignas(64) float mass;

// Warm data: 충돌 시에만 접근

alignas(64) collision_shape_t collision_shape;

alignas(64) material_properties_t material;

// Cold data: 초기화/디버깅 시에만 접근

debug_info_t debug_info;

creation_timestamp_t timestamp;

} physics_object_soa_t; // Structure of Arrays 방식

// 캐시 친화적 물리 시뮬레이션 루프

void cache_optimized_physics_simulation(physics_object_soa_t* objects, int count) {

const int CACHE_BLOCK_SIZE = 16; // 캐시 라인에 맞는 객체 수

// Step 1: 힘 계산 (벡터화 가능)

for(int block = 0; block < count; block += CACHE_BLOCK_SIZE) {

int block_size = min(CACHE_BLOCK_SIZE, count - block);

// SIMD를 활용한 벡터화된 힘 계산

calculate_forces_vectorized(&objects[block], block_size);

}

// Step 2: 적분 (위치 업데이트)

for(int block = 0; block < count; block += CACHE_BLOCK_SIZE) {

int block_size = min(CACHE_BLOCK_SIZE, count - block);

// 오일러 적분 또는 룽게-쿠타 방법

integrate_motion_vectorized(&objects[block], block_size, dt);

}

// Step 3: 충돌 검출 (공간 분할 활용)

broad_phase_collision_detection_cache_optimized(objects, count);

narrow_phase_collision_detection_cache_optimized(objects, count);

}

// 공간 분할을 활용한 캐시 효율적 충돌 검출

void spatial_partitioning_cache_optimized(physics_object_soa_t* objects, int count) {

// 8x8x8 그리드로 공간 분할

const int GRID_SIZE = 8;

spatial_grid_t grid[GRID_SIZE][GRID_SIZE][GRID_SIZE];

// 객체를 그리드에 할당 (캐시 지역성 향상)

for(int i = 0; i < count; i++) {

int grid_x = (int)(objects[i].position[0] / CELL_SIZE) % GRID_SIZE;

int grid_y = (int)(objects[i].position[1] / CELL_SIZE) % GRID_SIZE;

int grid_z = (int)(objects[i].position[2] / CELL_SIZE) % GRID_SIZE;

add_object_to_grid_cell(&grid[grid_x][grid_y][grid_z], &objects[i]);

}

// 인접한 그리드 셀끼리만 충돌 검사 (캐시 미스 최소화)

for(int x = 0; x < GRID_SIZE; x++) {

for(int y = 0; y < GRID_SIZE; y++) {

for(int z = 0; z < GRID_SIZE; z++) {

check_collisions_within_cell(&grid[x][y][z]);

// 인접 셀과의 충돌도 검사

check_collisions_between_adjacent_cells(&grid[x][y][z], x, y, z);

}

}

}

}Epic Games의 Unreal Engine 5 기술 문서에 따르면,

캐시 최적화를 통해 물리 시뮬레이션 성능을 3-5배 향상시킬 수 있다고 보고되었습니다.

캐시 일관성 벤치마킹과 성능 측정 방법론

정확한 성능 측정과 최적화 효과 검증을 위한 체계적인 벤치마킹 방법론을 제시합니다.

표준화된 캐시 일관성 벤치마크

// 종합적인 캐시 일관성 성능 벤치마크 스위트

typedef struct {

uint64_t cache_hits_l1;

uint64_t cache_misses_l1;

uint64_t cache_hits_l2;

uint64_t cache_misses_l2;

uint64_t cache_hits_l3;

uint64_t cache_misses_l3;

uint64_t false_sharing_events;

uint64_t coherency_messages;

uint64_t invalidations;

uint64_t writebacks;

double total_execution_time;

double cache_miss_penalty_avg;

} cache_performance_metrics_t;

// 마이크로벤치마크: False Sharing 성능 영향 측정

void benchmark_false_sharing_impact() {

printf("=== False Sharing 성능 영향 벤치마크 ===\n");

// 테스트 1: False Sharing 발생 구조

struct {

volatile int counter1;

volatile int counter2;

volatile int counter3;

volatile int counter4;

} false_sharing_data;

// 테스트 2: False Sharing 방지 구조

struct {

alignas(64) volatile int counter1;

alignas(64) volatile int counter2;

alignas(64) volatile int counter3;

alignas(64) volatile int counter4;

} cache_aligned_data;

const int ITERATIONS = 10000000;

const int NUM_THREADS = 4;

// False Sharing 케이스 측정

double false_sharing_time = measure_multithread_increment(

&false_sharing_data, NUM_THREADS, ITERATIONS);

// 캐시 정렬 케이스 측정

double cache_aligned_time = measure_multithread_increment(

&cache_aligned_data, NUM_THREADS, ITERATIONS);

printf("False Sharing 시간: %.2f ms\n", false_sharing_time);

printf("캐시 정렬 시간: %.2f ms\n", cache_aligned_time);

printf("성능 향상: %.2fx\n", false_sharing_time / cache_aligned_time);

}

// 메가벤치마크: 실제 워크로드 패턴 시뮬레이션

void benchmark_realistic_workloads() {

printf("=== 실제 워크로드 시뮬레이션 벤치마크 ===\n");

// 워크로드 1: 데이터베이스 스타일 (랜덤 접근)

cache_performance_metrics_t db_metrics =

benchmark_database_workload(1000000, 4);

// 워크로드 2: 스트리밍 스타일 (순차 접근)

cache_performance_metrics_t streaming_metrics =

benchmark_streaming_workload(1000000, 4);

// 워크로드 3: 과학 계산 스타일 (블록 접근)

cache_performance_metrics_t scientific_metrics =

benchmark_scientific_workload(1000000, 4);

print_detailed_metrics("Database Workload", &db_metrics);

print_detailed_metrics("Streaming Workload", &streaming_metrics);

print_detailed_metrics("Scientific Workload", &scientific_metrics);

}

// 적응형 성능 측정 (하드웨어 카운터 활용)

cache_performance_metrics_t measure_with_hardware_counters(

void (*workload_func)(void*), void* workload_data) {

cache_performance_metrics_t metrics = {0};

// Linux perf 이벤트 설정

int perf_fds[8];

perf_fds[0] = setup_perf_counter("cache-references");

perf_fds[1] = setup_perf_counter("cache-misses");

perf_fds[2] = setup_perf_counter("L1-dcache-loads");

perf_fds[3] = setup_perf_counter("L1-dcache-load-misses");

perf_fds[4] = setup_perf_counter("LLC-loads");

perf_fds[5] = setup_perf_counter("LLC-load-misses");

perf_fds[6] = setup_perf_counter("node-loads");

perf_fds[7] = setup_perf_counter("node-load-misses");

// 측정 시작

struct timespec start_time, end_time;

clock_gettime(CLOCK_MONOTONIC, &start_time);

for(int i = 0; i < 8; i++) {

ioctl(perf_fds[i], PERF_EVENT_IOC_RESET, 0);

ioctl(perf_fds[i], PERF_EVENT_IOC_ENABLE, 0);

}

// 워크로드 실행

workload_func(workload_data);

// 측정 종료

for(int i = 0; i < 8; i++) {

ioctl(perf_fds[i], PERF_EVENT_IOC_DISABLE, 0);

}

clock_gettime(CLOCK_MONOTONIC, &end_time);

// 결과 수집

uint64_t counter_values[8];

for(int i = 0; i < 8; i++) {

read(perf_fds[i], &counter_values[i], sizeof(uint64_t));

close(perf_fds[i]);

}

metrics.total_execution_time =

(end_time.tv_sec - start_time.tv_sec) +

(end_time.tv_nsec - start_time.tv_nsec) / 1e9;

metrics.cache_hits_l1 = counter_values[2] - counter_values[3];

metrics.cache_misses_l1 = counter_values[3];

metrics.cache_hits_l3 = counter_values[4] - counter_values[5];

metrics.cache_misses_l3 = counter_values[5];

return metrics;

}결론: 캐시 일관성 마스터리를 위한 실천 지침

캐시 일관성은 현대 멀티코어 시스템의 핵심 기술로, 시스템의 정확성과 성능에 직접적이고 결정적인 영향을 미칩니다.

본 가이드를 통해 다룬 핵심 내용들을 종합하면 다음과 같습니다.

핵심 포인트 요약

1. 하드웨어 이해의 중요성

- MESI 프로토콜과 그 변형들의 동작 원리

- 현대 CPU 아키텍처의 캐시 계층 구조

- 버스 스누핑과 디렉토리 기반 일관성 메커니즘

2. 실무 최적화 기법

- False Sharing 탐지 및 해결 방법

- 캐시 친화적 데이터 구조 설계

- NUMA-aware 프로그래밍 기법

3. 성능 분석과 디버깅

- 하드웨어 성능 카운터 활용법

- 전문 프로파일링 도구 사용법

- 체계적인 벤치마킹 방법론

4. 미래 기술 동향

- AI 기반 적응형 캐시 관리

- 새로운 메모리 기술과의 융합

- 차세대 인터커넥트 기술

실무 적용을 위한 체크리스트

개발자들이 실제 프로젝트에서 캐시 일관성을 고려할 때 참고할 수 있는 실용적인 체크리스트를 제공합니다:

설계 단계

- 공유 데이터 구조에서 False Sharing 가능성 검토

- 캐시 라인 크기(64바이트)를 고려한 데이터 정렬

- Hot/Cold 데이터 분리 설계

- NUMA 토폴로지를 고려한 메모리 할당 전략

구현 단계

- 원자적 연산과 메모리 베리어 적절한 사용

- Lock-free 알고리즘 적용 시 ABA 문제 고려

- 벡터화 가능한 루프 구조로 작성

- 캐시 친화적 메모리 접근 패턴 구현

테스트 및 최적화 단계

- 멀티스레드 환경에서의 성능 측정

- 하드웨어 카운터를 통한 캐시 미스율 분석

- False Sharing 탐지 도구 활용

- 다양한 워크로드 패턴에서의 벤치마킹

산업별 특화 고려사항

금융 시스템

- 마이크로초 단위 최적화가 필요한 경우 하드웨어 트랜잭션 메모리(TSX) 활용

- 거래 데이터의 캐시 워밍업 전략 구현

- NUMA 토폴로지를 고려한 거래 엔진 배치

게임 엔진

- 실시간 렌더링을 위한 구조체 배열(SoA) 방식 적용

- GPU-CPU 간 메모리 일관성 관리

- 물리 시뮬레이션의 공간 분할을 통한 캐시 지역성 향상

데이터베이스 시스템

- 인덱스 구조의 캐시 친화적 설계

- 트랜잭션 로그의 순차 쓰기 최적화

- 버퍼 풀 관리와 캐시 일관성 연동

과학 계산

- 대용량 행렬 연산의 블록 단위 처리

- 메모리 대역폭 최적화를 위한 데이터 레이아웃

- 분산 메모리 시스템에서의 캐시 일관성 관리

최신 하드웨어별 최적화 가이드

Intel Xeon (Sapphire Rapids)

// Intel의 최신 아키텍처 특화 최적화

void intel_sapphire_rapids_optimization() {

// Advanced Matrix Extensions (AMX) 활용

if (cpu_supports_amx()) {

enable_amx_tile_config();

use_amx_for_matrix_operations();

}

// Dynamic Load Balancing (DLB) 활용

if (cpu_supports_dlb()) {

configure_dynamic_load_balancing();

}

// Cache QoS (Quality of Service) 설정

configure_cache_allocation_technology();

}AMD EPYC (Zen 4)

// AMD 최신 아키텍처 특화 최적화

void amd_zen4_optimization() {

// Infinity Fabric 최적화

configure_infinity_fabric_clocks();

// L3 캐시 슬라이싱 최적화

optimize_l3_cache_slicing();

// NUMA 도메인 최적화

configure_preferred_numa_domains();

}ARM Neoverse (V2)

// ARM 서버 프로세서 최적화

void arm_neoverse_optimization() {

// Scalable Vector Extensions (SVE2) 활용

if (cpu_supports_sve2()) {

enable_sve2_vector_operations();

}

// Cache Stashing 기능 활용

configure_cache_stashing_policies();

// Memory Tagging Extensions (MTE) 활용

if (cpu_supports_mte()) {

enable_memory_tagging_for_cache_debugging();

}

}캐시 일관성 관련 보안 고려사항

현대 시스템에서는 캐시 일관성과 관련된 보안 취약점도 고려해야 합니다.

사이드 채널 공격 방어

// 캐시 타이밍 공격 방어를 위한 일정 시간 실행 보장

void constant_time_cache_access(void* data, size_t size) {

// 모든 캐시 라인을 동일하게 접근하여 타이밍 패턴 숨김

volatile char dummy;

for(size_t i = 0; i < size; i += CACHE_LINE_SIZE) {

dummy = ((volatile char*)data)[i];

}

// 메모리 베리어로 추측 실행 방지

memory_barrier_full();

}

// 투기적 실행 공격 방어

void speculative_execution_mitigation() {

// LFENCE 명령어로 추측 실행 경계 설정

asm volatile("lfence" ::: "memory");

// 조건부 접근 시 인덱스 마스킹

if (user_input < array_size) {

// Spectre v1 방어: 인덱스 마스킹

size_t safe_index = user_input & (array_size - 1);

process_array_element(safe_index);

}

}차세대 메모리 기술과의 융합

Processing-in-Memory (PIM) 기술

// 메모리 내 처리 기능을 활용한 캐시 우회

typedef struct {

pim_device_t* device;

void* host_memory;

void* device_memory;

coherency_protocol_t coherency_type;

} pim_cache_system_t;

void pim_enhanced_computation(pim_cache_system_t* system,

computation_task_t* task) {

// 데이터가 이미 메모리에 있는 경우 캐시 우회하여 직접 처리

if (is_data_in_pim_memory(task->data)) {

execute_computation_in_memory(system->device, task);

// 결과만 캐시로 가져와서 CPU와 일관성 유지

coherent_transfer_result(system, task->result);

} else {

// 전통적인 CPU-캐시 경로 사용

traditional_cpu_computation(task);

}

}Compute Express Link (CXL) 기술

// CXL을 통한 확장된 메모리 계층과 캐시 일관성

typedef struct {

cxl_device_t* cxl_memory;

cache_coherency_domain_t coherency_domain;

memory_semantic_t semantic_type; // CXL.mem or CXL.cache

} cxl_cache_extension_t;

void cxl_coherent_memory_access(cxl_cache_extension_t* cxl_system,

memory_request_t* request) {

if (cxl_system->semantic_type == CXL_CACHE_SEMANTIC) {

// CXL.cache: 하드웨어 캐시 일관성 자동 관리

hardware_coherent_access(cxl_system->cxl_memory, request);

} else {

// CXL.mem: 소프트웨어 일관성 관리 필요

software_managed_coherency(cxl_system, request);

}

}개발자를 위한 최종 권장사항

1. 점진적 최적화 접근법

- 먼저 정확성을 보장하는 단순한 구현으로 시작

- 성능 프로파일링을 통해 병목 지점 식별

- 측정된 데이터를 기반으로 단계적 최적화 수행

2. 휴대성과 성능의 균형

- 플랫폼별 최적화는 조건부 컴파일로 분리

- 기본 구현은 표준 C/C++ 기능만 사용

- 하드웨어별 최적화는 런타임 감지 후 적용

3. 지속적인 학습과 적응

- 새로운 하드웨어 아키텍처의 특징 학습

- 최신 컴파일러 최적화 기법 활용

- 커뮤니티와 연구 동향 지속적 모니터링

추가 학습 리소스

공식 문서 및 사양서

- Intel 64 and IA-32 Architectures Optimization Reference Manual

- AMD64 Architecture Programmer's Manual

- ARM Architecture Reference Manual

성능 분석 도구

연구 논문 및 기술 보고서

- Cache Coherence Protocol Verification Techniques

- Memory Consistency Models: A Tutorial

- False Sharing Detection and Repair

캐시 일관성은 복잡하지만 체계적인 접근을 통해 마스터할 수 있는 기술입니다.

하드웨어의 발전과 함께 계속 진화하는 이 분야에서,

기본 원리에 대한 깊은 이해와 실무 경험의 축적이 경쟁력 있는 고성능 소프트웨어 개발의 핵심이 될 것입니다.

현대 소프트웨어 개발에서 멀티코어 프로세서는 표준이 되었으므로,

캐시 일관성에 대한 깊은 이해는 모든 시스템 프로그래머와 성능 엔지니어에게 필수적인 지식입니다.

본 가이드에서 제시한 이론적 배경과 실무적 기법들을 바탕으로,

더욱 효율적이고 확장 가능한 멀티코어 애플리케이션을 개발하시기 바랍니다.

'컴퓨터 과학(CS)' 카테고리의 다른 글

| API Rate Limiting 원리와 구현 전략: 안정적인 서비스를 위한 필수 기술 (0) | 2025.05.26 |

|---|---|

| 블룸 필터(Bloom Filter)란? – 검색 최적화의 핵심 자료구조 (0) | 2025.05.23 |

| OS 스케줄링 알고리즘 종류 및 작동 방식 완벽 가이드 (0) | 2025.05.23 |

| 동시성과 병렬성의 차이 – 예제 코드와 면접 답변 포함 (0) | 2025.05.23 |

| 메모리 계층 구조 이해: 레지스터, 캐시, RAM, 디스크 차이 (0) | 2025.05.18 |